Muito provavelmente, você conhece SEO e seus melhores usos: o valor da estrutura do site, as regras de marcação, o preenchimento de palavras-chave, o valor da otimização de conteúdo exclusivo, e outros, então você pode ter ouvido falar dos bots do Google. No entanto, o que você conhece dos bots do Google? Esse fenômeno difere da já conhecida otimização SEO, porque é realizada a um nível profundo. Se a otimização SEO lida com a otimização de um texto para consultas SE, o Google bot é um processo de otimização de sites para Google Spiders. Claro, esses processos têm semelhanças, mas nos permitam esclarecer suas principais diferenças porque isso pode influenciar profundamente no seu site. Aqui vou falar do fenômeno de rastreamento de site, pois é o principal problema no qual todos devem prestar atenção se falarmos de uma pesquisa de website.

Índice

- O que é Googlebot?

- 6 estratégias sobre como otimizar seu site melhor para o rastreamento do Googlebot

- Como analisar a atividade do Googlebot

O que é Googlebot?

Os rastreadores do site ou os bots do Google são robôs que examinam uma página da Web e criam um índice. Se uma página da Web permitir um acesso bot, esse bot adiciona esta página a um índice, e somente então, essa página torna-se acessível para os usuários. Se você deseja ver como esse processo é realizado, verifique aqui. Se você deseja entender o processo de otimização do Googlebot, você precisa entender como exatamente uma Google spider digitaliza um site. Aqui estão os quatro passos:

Se uma página da web tiver um alto nível de ranking de página, o Google Spider passará mais tempo rastreando.

Aqui podemos conversar sobre o “Crawl Budget”, que é a quantidade exata de tempo gasto por robôs da web na digitalização de um determinado site: quanto maior a autoridade da webpage mais budget irá receber.

Os robôs do Google rastreiam um site constantemente

O que o Google diz sobre isto: “o robô do Google não tem acesso a um site mais de uma vez a cada segundo”. Isso significa que o seu site está sob controle constante dos web spiders que tiverem acesso a ele. Hoje, muitos gerentes de SEO argumentam sobre a chamada “taxa de rastreamento” e tentam encontrar uma maneira ideal de rastrear o site para obter o nível mais alto no ranking. No entanto, podemos falar de erro de interpretação em “taxa de rastreamento” que é a velocidade dos pedidos do robô do Google, em vez de rastrear a repetição. Você pode até modificar as taxas utilizando as ferramentas para webmasters. O grande número de backlinks, singularidades e menções sociais influenciam sua posição nos resultados de pesquisa. Devemos também notar que as Web Spiders não digitalizam cada página constantemente, portanto, estratégias de conteúdos constantes são muito importantes, pois o conteúdo único e útil atrai a atenção do bot.

O arquivo Robots.txt é a primeira coisa que os robôs do Google exploram para obter um roteiro para o rastreamento do site.

Isso significa que se uma página estiver marcada como não permitida neste arquivo, os robôs não poderão digitalizar e indexar.

O Sitemap XML é um guia para os bots do Google

O Sitemap XML ajuda os robôs a descobrir quais locais precisam ser rastreados e indexados, pois pode haver diferenças na estrutura e organização do site, portanto, esse processo pode não ser automático O bom Sitemap pode ajudar as páginas como baixo nível de classificação, alguns backlinks e conteúdo inútil, além de ajudar o Google a lidar com imagens, notícias, vídeos, etc.

6 estratégias sobre como otimizar seu site melhor para o rastreamento do Googlebot

Como você entendeu, a otimização do Google Spider deve ser feita antes que qualquer etapa para a otimização do SE seja tomada. Assim, consideremos agora o que você deve fazer para facilitar o processo de indexação dos bots do Google.

Overdoing não é bom

Você sabe que o Googlebots não pode scanear vários frames, Flash, JavaScript, DHTML, bem como o conhecido HTML. Além disso, o Google ainda não esclareceu se o Googlebot é capaz de rastrear o Ajax e o JavaScript, portanto é melhor você não os usar ao criar seu site. Embora o Matt Cutts declare que o JavaScript pode ser aberto para web spiders, tais evidências como as Diretrizes para webmasters do Google refutam isso: “Se coisas como cookies, vários frames, Flash ou Java Script não podem ser vistos em um navegador de texto, as spiders não poderão rastrear esse site.” Para mim o JavaScript não pode ser usado demais.

Não subestime o arquivo robots.txt

Você já pensou no propósito do arquivo robot.txt? É o arquivo mais utilizado em muitas estratégias de SEO, mas é realmente útil? Em primeiro lugar, este arquivo é uma diretriz para todas as web spiders, portanto o robô do Google irá gastar “crawl budget” em qualquer página do seu website. Em segundo lugar, você deve decidir em qual arquivo os robôs devem escanear, portanto, se houver um arquivo que seja proibido rastrear, você poderá indicá-lo no seu arquivo robots.txt. Por que fazer isso? Se houver páginas que não devem ser rastreadas, o Googlebot irá ver imediatamente e digitalizará a parte mais importante do seu site. No entanto, minha sugestão não bloqueia o que deve ser bloqueado. Se você não indicar que algo não é permitido rastrear, o bot irá rastrear tudo por padrão. Assim, a função principal do arquivo robots.txt irá indicar onde ele não deveria ir.

O conteúdo útil e exclusivo realmente importa

A regra é que o conteúdo que é rastreado com mais frequência, tem como resultado um maior tráfego. Apesar de o PageRank determinar a frequência do rastreamento, ele pode se desviar quando se fala de utilidade e atualizações das páginas que possuem um PageRank similar. Assim, o objetivo principal é escanear regularmente as páginas com ranking baixo. AJ Kohn disse uma vez: “Você é um vencedor se você transformar as suas páginas com ranking baixo, naquelas que são escaneadas mais frequentemente do que as concorrentes.”

Obtendo páginas de rolagem mágica

Se o seu site tiver essas páginas de rolagem infinitas, isso não significa que você não tem chances de otimização do Googlebot. Portanto, você deve se certificar de que essas páginas da Web estejam de acordo com as diretrizes do Google.

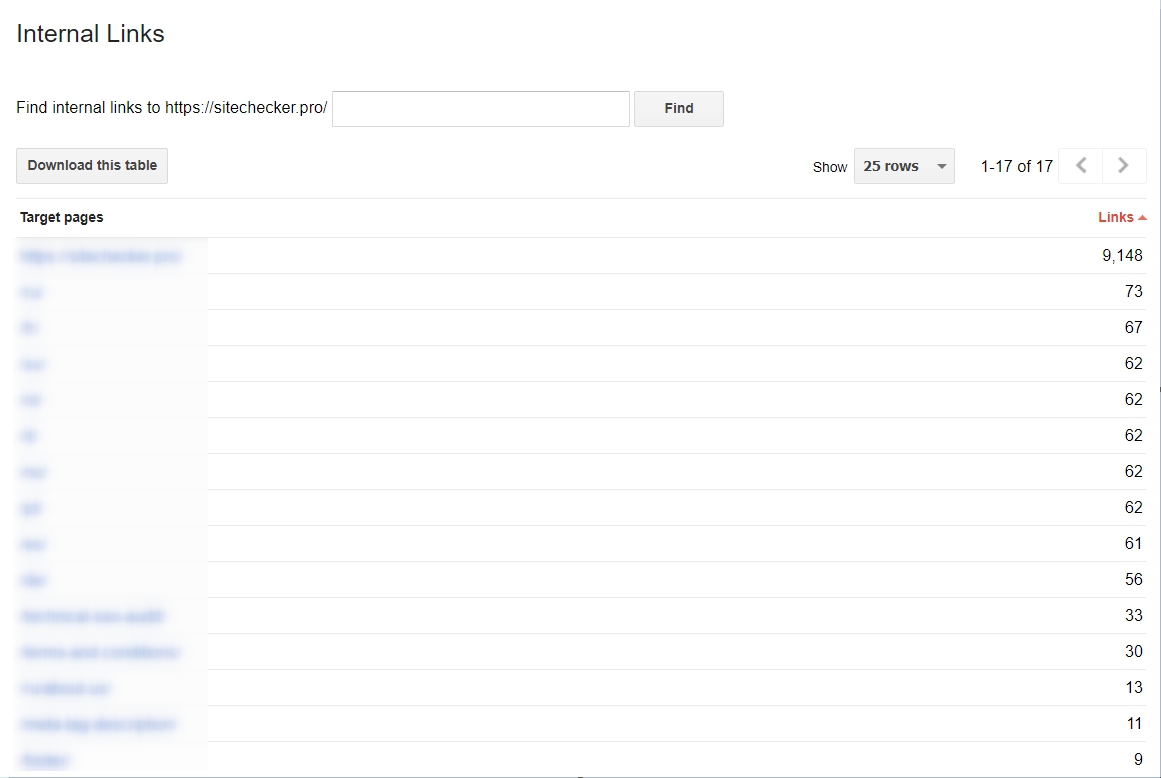

Você deve começar a usar links internos

Isso é muito importante utilizar se você deseja tornar o processo de digitalização muito mais fácil para o Googlebots. Se seus links forem pequenos e consolidados, o processo de digitalização será muito mais eficaz. Se você deseja obter uma análise de seus hiperlinks internos, você pode fazer isso acessando as ferramentas do Google para webmasters, busque então Tráfego e escolha a seção Ligações Internas. Se as páginas da Web estão no topo da lista, elas contêm um conteúdo útil.

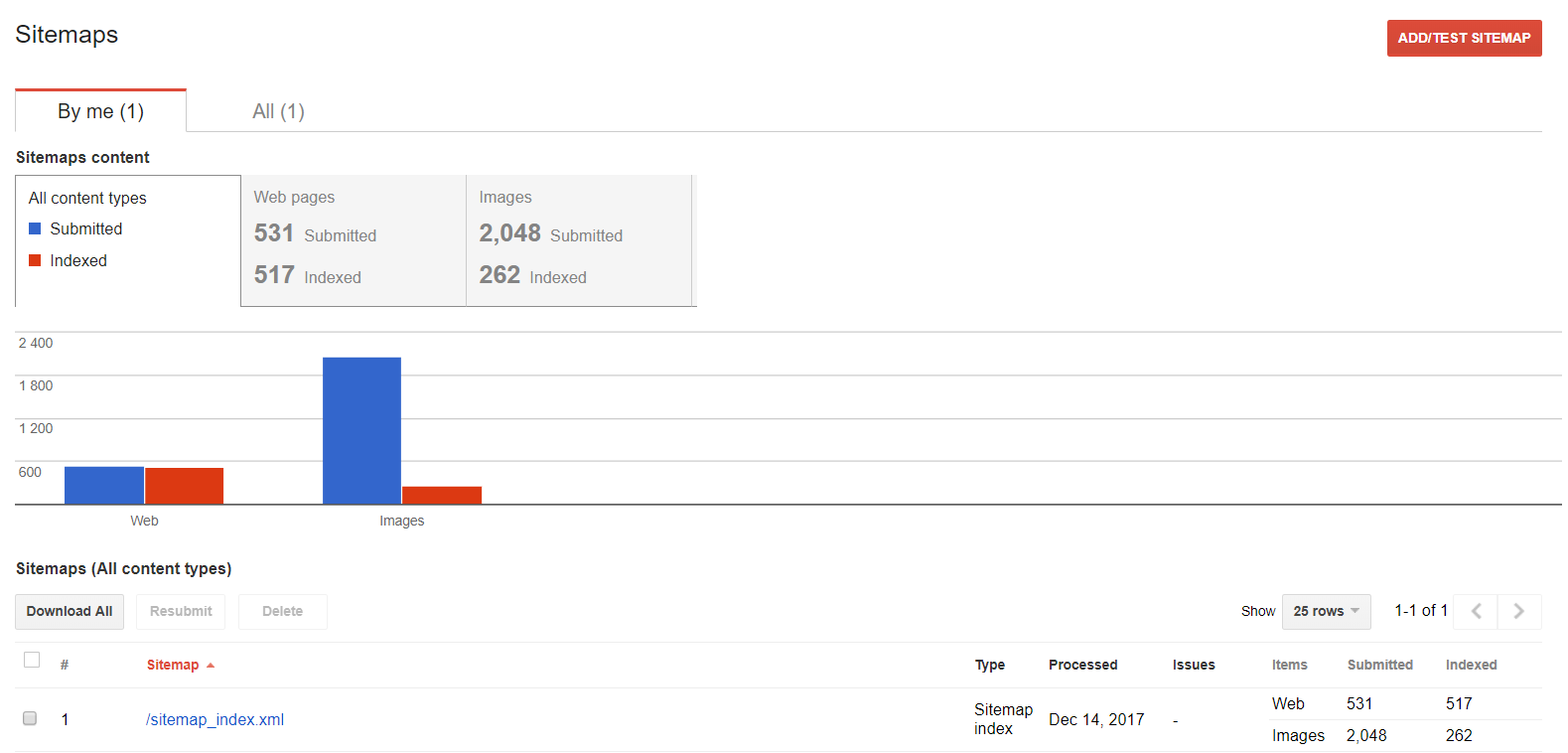

Sitemap.xml é vital

O sitemap fornece instruções para o Googlebot sobre como acessar um site; é simplesmente um mapa para seguir. Por que é utilizado então? muitos sites hoje não são fáceis de digitalizar, e essas dificuldades podem tornar o processo de rastreamento muito complicado. Assim, as seções do seu site que podem confundir a web spider estão indicadas no sitemap, e isso pode garantir que todas as áreas do site sejam rastreadas.

Como analisar a atividade do Googlebot?

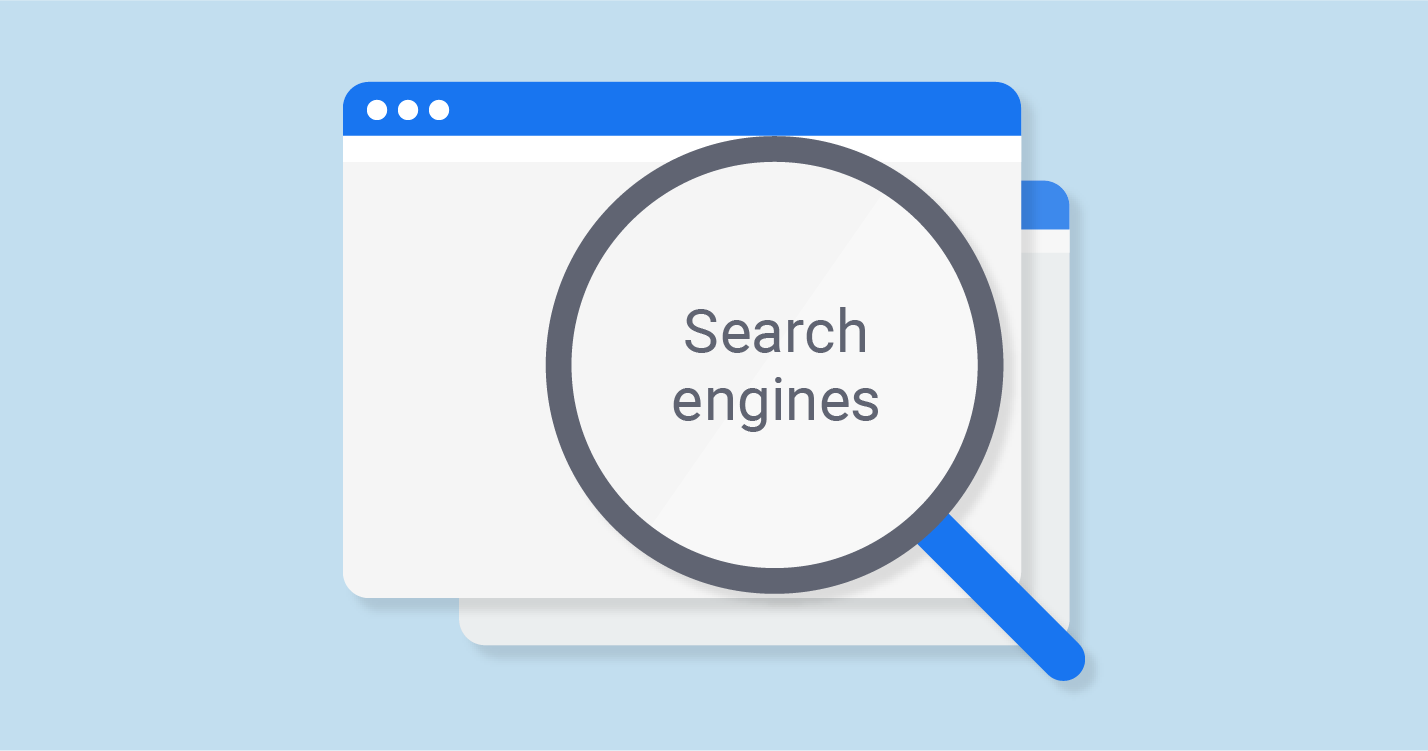

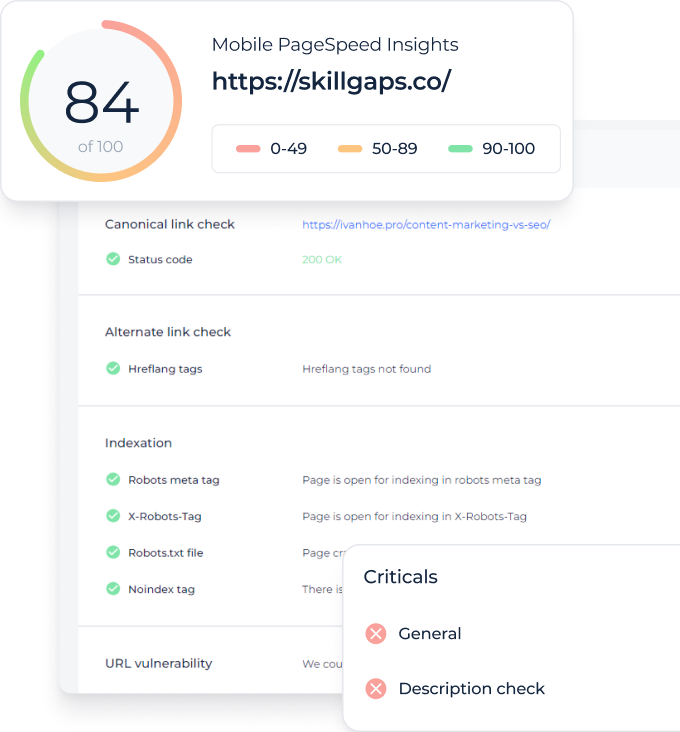

Se você deseja ver a atividade do Googlebot realizada em seu site, você poderá utilizar as ferramentas do Google para webmasters. Além disso, aconselhamos que você verifique regularmente os dados fornecidos por este serviço, pois mostrará se ocorrem alguns problemas ao rastrear. Basta verificar a seção “Rastrear” em suas ferramentas para webmasters.

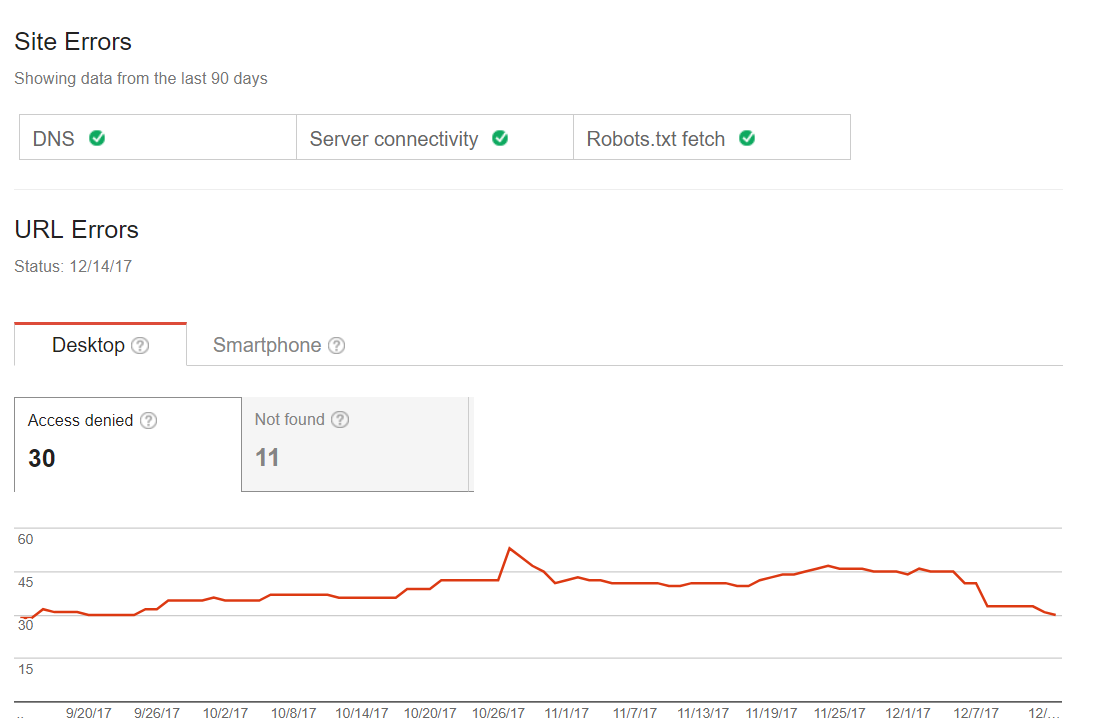

Erros comuns de rastreamento

Você pode verificar se seu site enfrenta problemas com o processo de digitalização. Assim, você não terá nenhum problema de status ou terá bandeiras vermelhas, por exemplo, páginas que deveriam ter sido carregadas a partir último link. Portanto, eis o primeiro passo que você deve seguir, quando se fala de otimização do Googlebot. Alguns sites podem ter pequenos erros de varredura, mas isso não significa que eles irão influenciar o tráfego ou ranking. No entanto, com a passagem do tempo, tais problemas podem resultar em declínio do tráfego. Aqui você pode encontrar alguns exemplos de tal site:

Sitemaps

Você pode usar essa função se desejar trabalhar com seu sitemap: examine, adicione ou descubra o conteúdo que está sendo indexado.

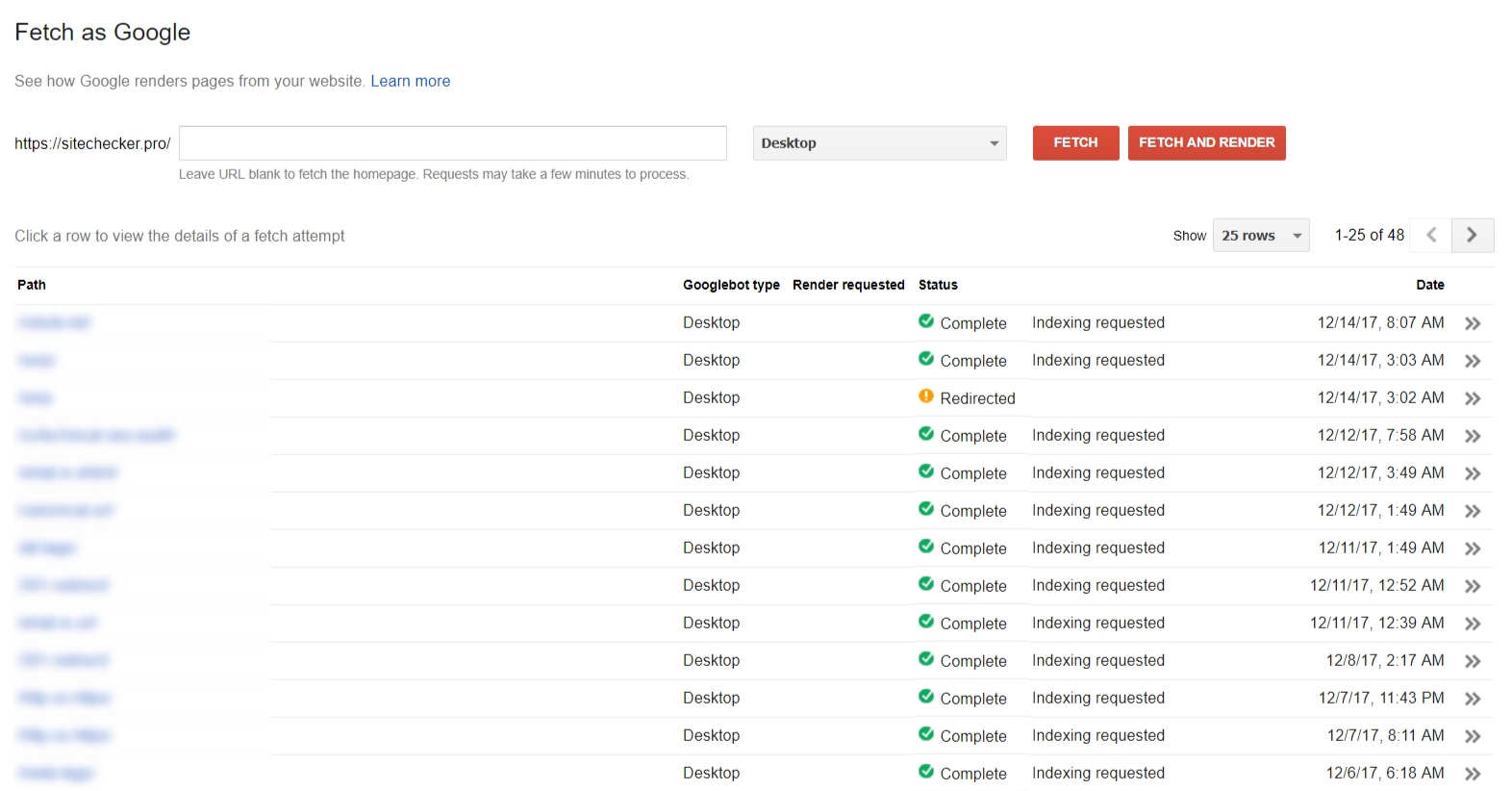

Fetching

A Seção “Buscar como Google” ajuda você a ver seu site / página da maneira como o Google o vê.

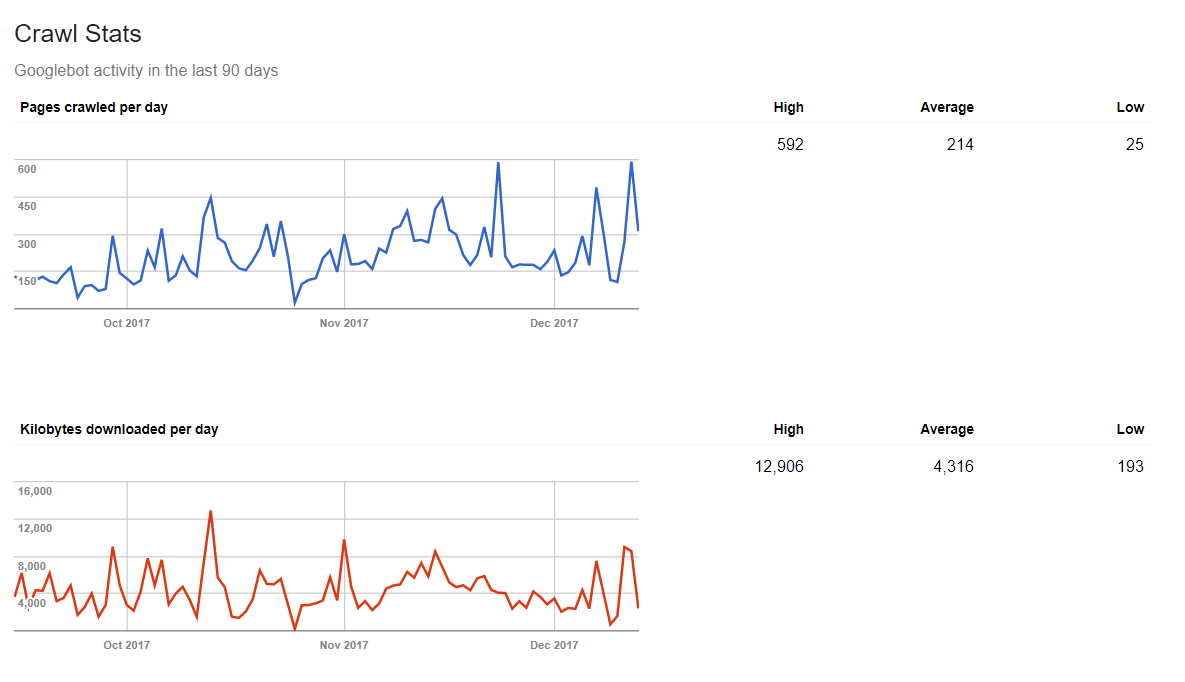

Estatísticas de rastreamento

O Google também poderá lhe dizer a quantidade de dados processados por dia pelo web spider. Assim, se você publicar um conteúdo novo regularmente, você terá um resultado estatisticamente positivo.

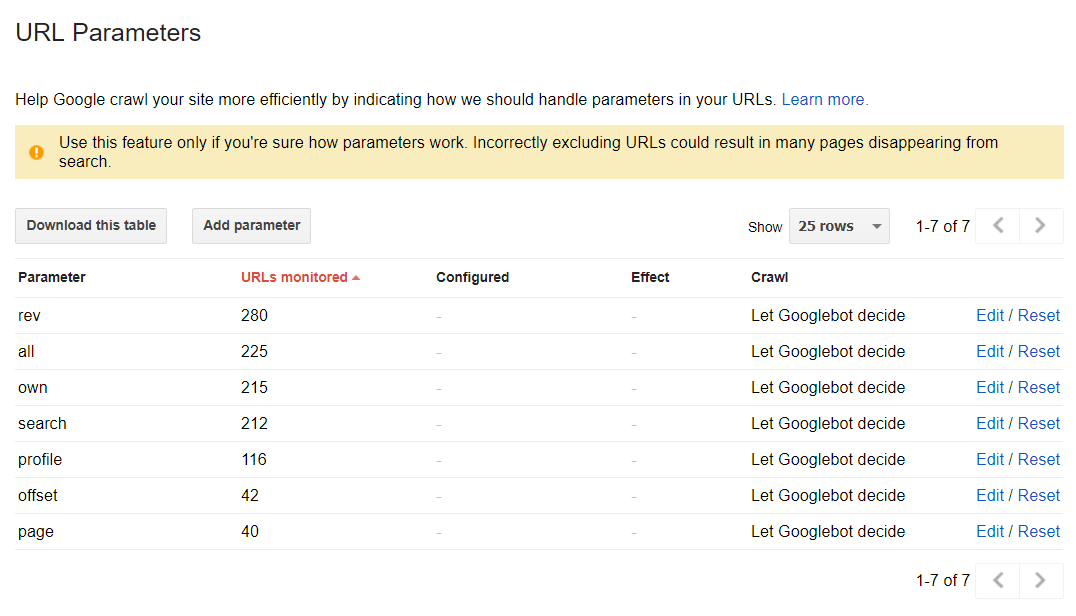

Os parâmetros do URL

Esta seção pode ajudá-lo a descobrir como o Google rastreia e indexa seu site, usando parâmetros URL. No entanto, no modo padrão, todas as páginas são rastreadas devido as decisões da web spider: