Molto probabilmente sei a conoscenza del SEO e delle sue migliori pratiche: il valore della struttura del sito web, le regole di tagging, il riempimento delle parole chiave, il valore dell’ottimizzazione dei contenuti per e altri, quindi potresti aver sentito parlare dei bot di Google. Tuttavia, cosa sai dei bot di Google? Questo fenomeno differisce da un ben noto ottimizzazione SEO, perché viene eseguito a livello profondo. Se l’ottimizzazione SEO riguarda l’ottimizzazione di un testo per le query SE, Google Bot One è un processo di ottimizzazione del sito Web per gli spider di Google. Certo, questi processi hanno delle somiglianze, ma chiariamo la loro principale differenza perché potrebbe influenzare profondamente il tuo sito. Qui parlerò di un fenomeno del tipo “crawlability” del sito, in quanto è il problema principale a cui tutti dovrebbero prestare attenzione se parliamo di una ricerca sul sito web.

Cos’è Googlebot?

I crawler dei siti o i robot di Google sono robot che esaminano una pagina Web e creano un indice. Se una pagina web consente l’accesso a un bot, questo bot aggiunge questa pagina a un indice e solo allora questa pagina diventa accessibile agli utenti. Se desideri vedere come viene eseguita questa procedura, controlla qui. Se desideri comprendere il processo di ottimizzazione di Googlebot, devi chiarire in che modo esattamente uno spider di Google esegue la scansione di un sito. Ecco questi quattro passaggi:

Se una pagina web ha un livello di classificazione delle pagine elevato, lo spider di Google impiegherà più tempo per la scansione.

Qui possiamo parlare di “Budget della scansione”, ovvero una quantità esatta di tempo speso dai robot Web per la scansione di un determinato sito: l’autorità più elevata di una pagina Web riceverà il budget più alto.

I robot di Google eseguono la scansione di un sito Web costantemente

Ecco cosa dice Google a proposito di questo: “Google robot non deve accedere a un sito web più di una volta al secondo”. Ciò significa che il tuo sito web è sotto il controllo costante degli spider web se hanno accesso ad esso. Oggi molti gestori SEO discutono sulla cosiddetta “velocità di scansione” e cercano di trovare un modo ottimale di scansione del sito per ottenere un livello di alto livello. Tuttavia, qui possiamo parlare di errata interpretazione come “velocità di scansione” non è altro che una velocità delle richieste dei robot di Google piuttosto che la ripetizione di scansione. Puoi persino modificare questo tasso utilizzando gli Strumenti per i Webmaster. L’enorme numero di ritroso, unicità e menzioni sociali influenzano la tua posizione nei risultati di ricerca. Dovrei anche notare che i web spider non scandiscono costantemente ogni pagina, quindi, le strategie di contenuto costante sono molto importanti in quanto i contenuti unici e utili attirano l’attenzione del bot.

Il file Robots.txt file è la prima cosa che i robot di Google scansionano per avere una roadmap per il crawling del sito

Ciò significa che se una pagina è contrassegnata come non consentita in questo file, i robot non saranno in grado di eseguire la scansione e indicizzarla.

XML sitemap è una guida per i Google bots

XML sitemap aiuta i robot a scoprire quali posti del sito web devono essere sottoposti a scansione e indicizzazione, in quanto potrebbero esserci differenze nella struttura e nell’organizzazione del sito Web, pertanto questo processo potrebbe non essere automatico. Una buona Sitemap può aiutare le pagine con un basso ranking, controllare un piccolo numero di backlink usando backlink checker e contenuti inutili, e anche aiutare Google a gestire immagini, notizie, video, ecc.

6 strategie su come ottimizzare il tuo sito in modo migliore per la scansione di Googlebot

Come hai capito, l’ottimizzazione dello spider di Google deve essere eseguita prima che venga effettuato qualsiasi passaggio per l’ottimizzazione SE. Pertanto, consideriamo ora che cosa dovresti fare per facilitare il processo di indicizzazione per i robot di Google.

Esagerare non va bene

Sai che Googlebots non può eseguire la scansione di vari frame, Flash, JavaScript, DHTML e HTML ben noto. Inoltre, Google non ha ancora chiarito se Googlebot sia in grado di eseguire la scansione di Ajax e JavaScript, pertanto è preferibile non utilizzarli durante la creazione del sito web. Sebbene Matt Cutts affermi che JavaScript può essere aperto per i web spider, tali prove come le Istruzioni per i webmaster di Google confutano questo: “Se i cookie, i vari frame, Flash o JavaScript non possono essere visti in un browser di testo, allora i web spider potrebbero non essere in grado di eseguire la scansione di questo sito Web. “A mio parere, JavaScript non deve essere abusato.

Non sottostimare il file robots.txt

Hai mai pensato allo scopo del file robots.txt? È il file comune utilizzato in molte strategie SEO, ma è davvero utile? In primo luogo, questo file è una direttiva per tutti gli spider web, quindi Google robot spenderà il “budget di ricerca per indicizzazione” in qualsiasi pagina web del tuo sito. In secondo luogo, dovresti decidere tu stesso quale file devono scansionare i bot, quindi se c’è un file che non è autorizzato a eseguire la scansione, puoi indicarlo nel tuo file robots.txt. Perché questo? Se ci sono pagine che non dovrebbero essere sottoposte a scansione, Google Bot lo vedrà immediatamente e analizzerà la parte del tuo sito, che è più importante. Tuttavia, il mio suggerimento non blocca ciò che non dovrebbe essere bloccato. Se non si indica che qualcosa non è consentito per la scansione, il bot eseguirà la scansione e indicizzerà tutto per impostazione predefinita. Pertanto, la funzione principale del file robots.txt indica dove non dovrebbe andare.

I contenuti utili e unici contano davvero

La regola è che i contenuti sottoposti a scansione sono più frequenti e, di conseguenza, il traffico aumenta. Nonostante il PageRank determini la frequenza di scansione, può farsi da parte quando parla dell’utilità e della freschezza delle pagine che hanno un PageRank simile. Pertanto, il tuo obiettivo principale è quello di ottenere scansioni regolari delle pagine di basso livello. AJ Kohn una volta ha detto: “Sei un vincitore se hai trasformato le tue pagine di basso livello in quelle che sono state scansionate più spesso delle competizioni.”

Ottenere pagine di scorrimento magiche

Se il tuo sito contiene quelle pagine che scorrono all’infinito, ciò non significa che non hai possibilità di ottimizzare Googlebot. Pertanto, dovresti assicurarti che queste pagine web siano conformi alle linee guida di Google.

Devi iniziare a usare i link interni

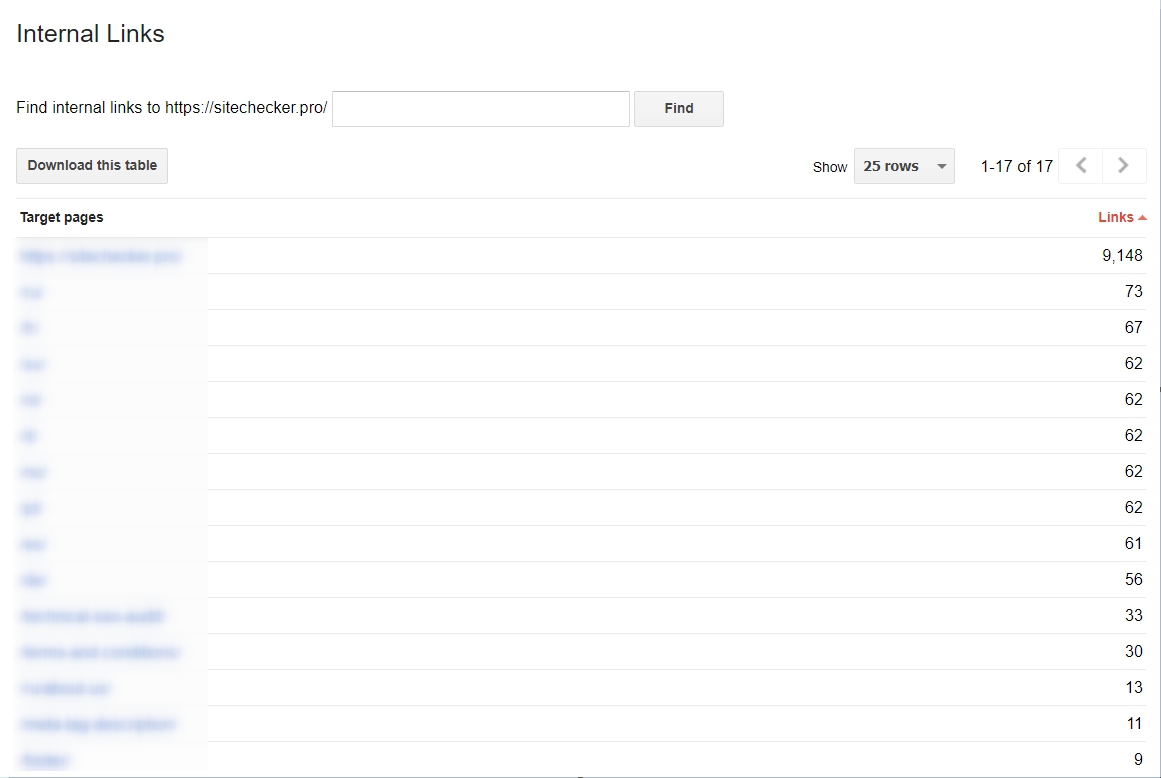

È molto importante da utilizzare se desideri rendere molto più facile la scansione di Googlebots. Se i tuoi collegamenti sono serrati e consolidati, il processo di scansione sarà molto efficace. Se desideri ottenere un’analisi dei tuoi collegamenti ipertestuali interni, puoi farlo andando su Strumenti per i Webmaster di Google, quindi su Traffico di ricerca e scegli la sezione Collegamenti interni. Se le pagine web sono in cima alla lista, contengono contenuti utili.

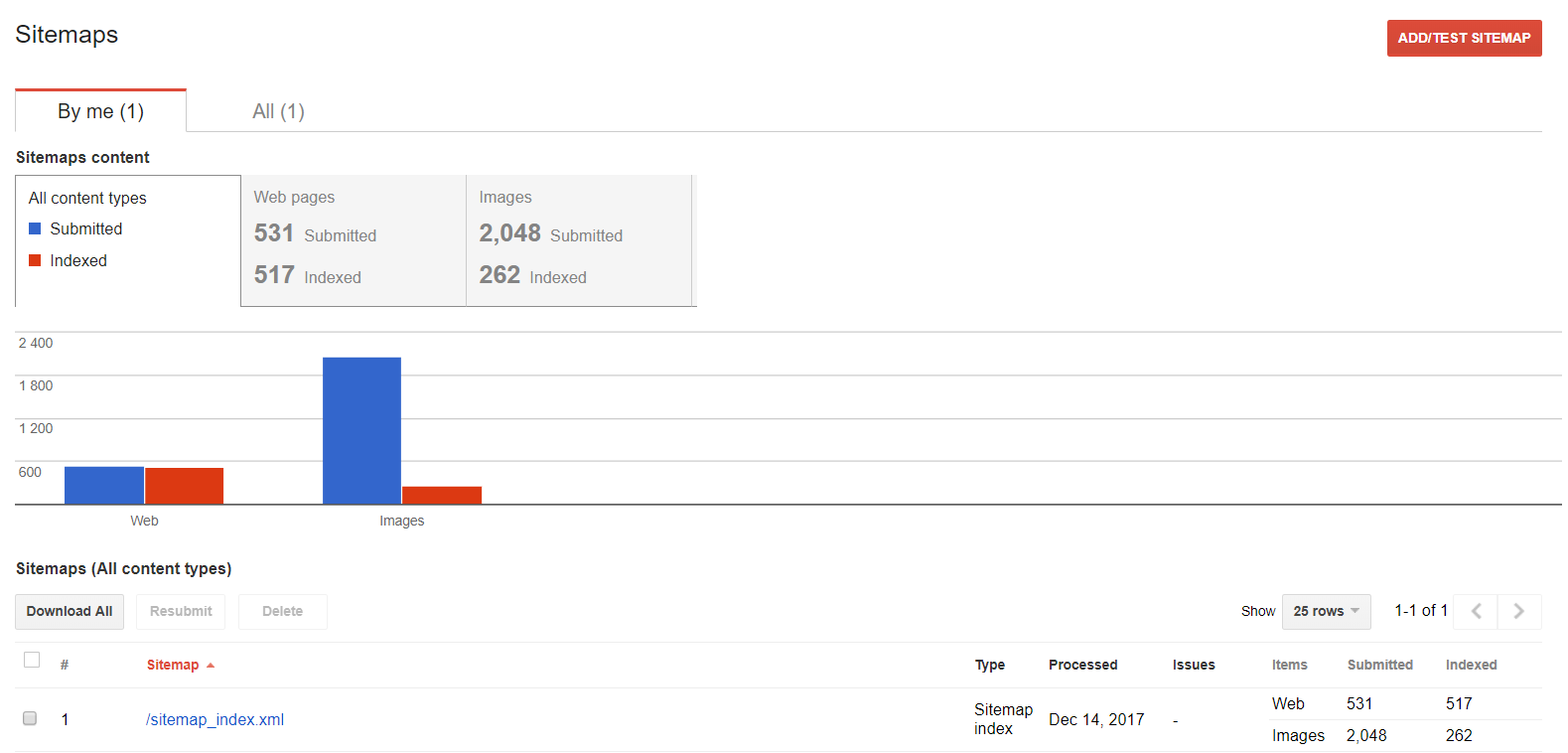

Sitemap.xml è vitale

La sitemap fornisce indicazioni per Googlebot su come accedere a un sito web; è semplicemente una mappa da seguire. Perché viene usata allora? Molti siti Web oggi non sono facili da analizzare e queste difficoltà possono rendere molto complicato il processo di scansione. Test sito web aiuta a conoscere meglio i punti deboli della pagina e ad eliminarli. Pertanto, le sezioni del tuo sito che possono confondere il web spider sono indicate in una sitemap, e questo può garantire che tutte le aree del sito Web vengano sottoposte a scansione.

Come analizzare l’attività di Googlebot?

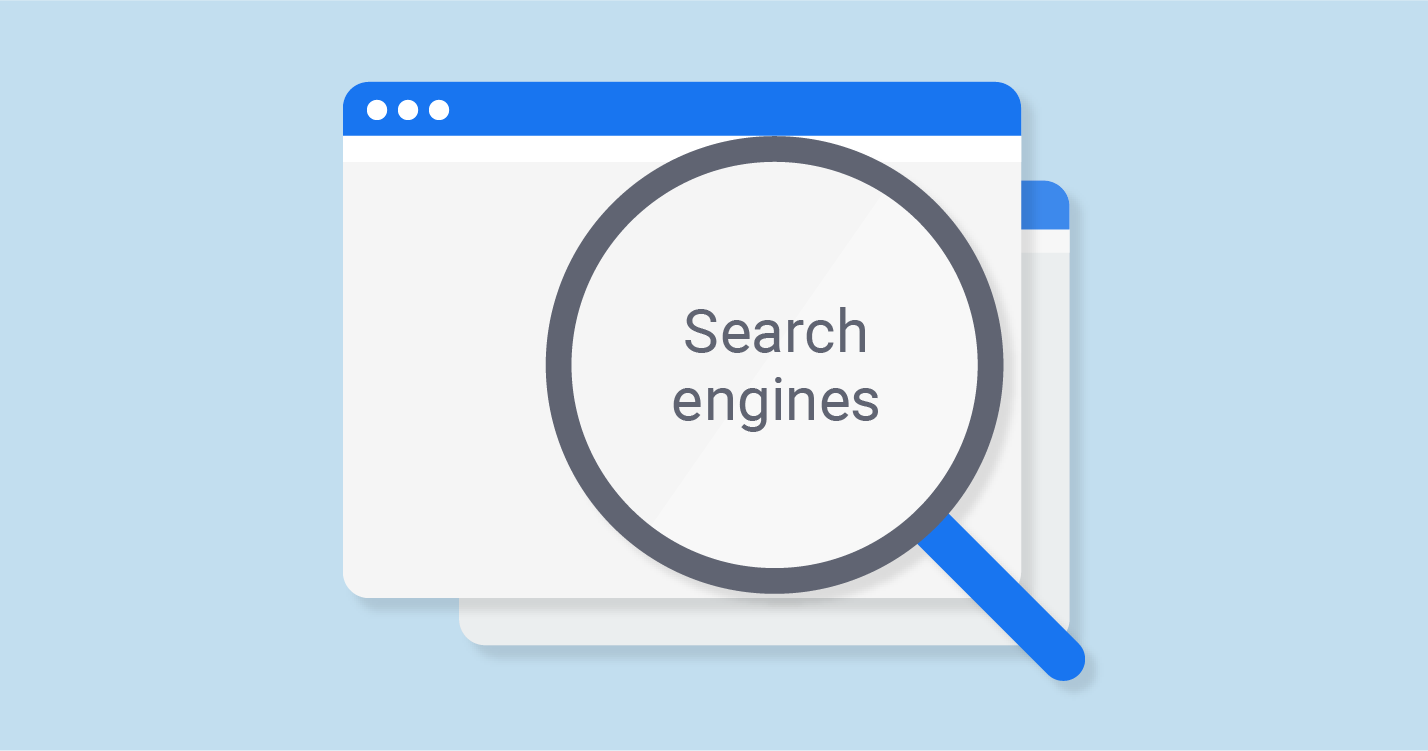

Se desideri vedere l’attività di Googlebot eseguita sul tuo sito, puoi utilizzare gli Strumenti per i Webmaster di Google. Inoltre, ti consiglio di controllare i dati forniti da questo servizio su base regolare, in quanto ti mostrerà se si verificano problemi durante la scansione. Basta controllare la sezione “Scansione” nei tuoi Strumenti per i Webmaster.

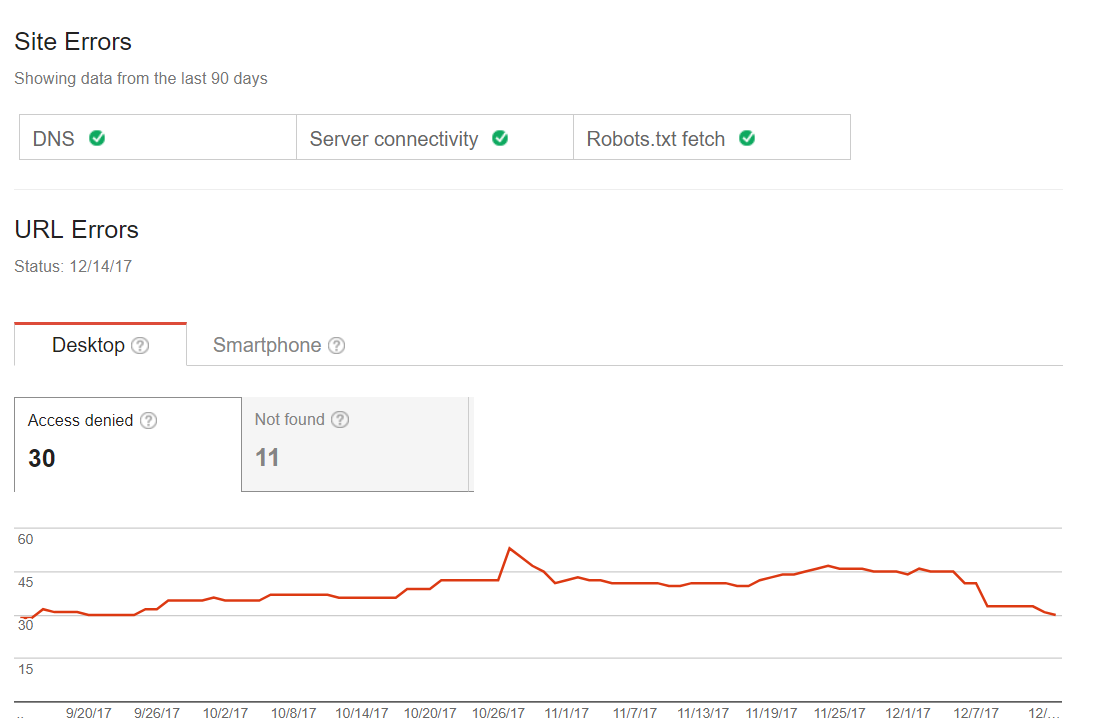

Errori comuni del crawling

Puoi verificare se il tuo sito ha problemi con il processo di scansione. Pertanto, non avrai nessuno stato di problemi o bandiere rosse, ad esempio pagine, che dovrebbero essere dovute all’ultimo indice. Quindi, il primo passo da fare, quando si parla dell’ottimizzazione di Googlebot. Alcuni siti Web potrebbero avere errori di scansione minori, ma ciò non significa che influenzeranno il traffico o la classifica. Tuttavia, con il passare del tempo, tali problemi possono comportare il declino del traffico. Qui puoi trovare un esempio di tale sito:

Sitemaps

Puoi utilizzare questa funzione se desideri lavorare con la tua sitemap: esaminare, aggiungere o scoprire quale contenuto viene indicizzato.

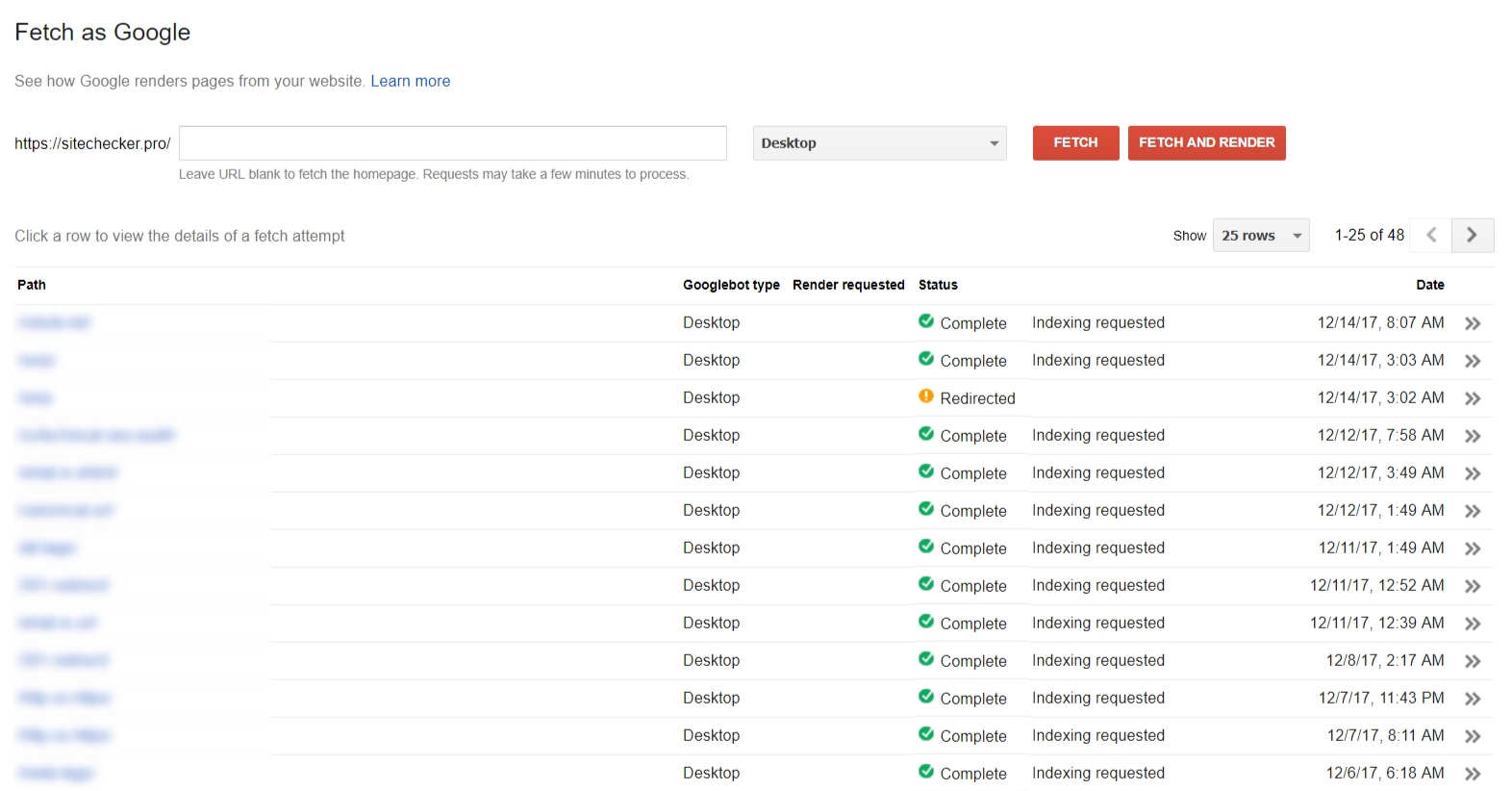

Fetching

La sezione “Visualizza come Google” ti aiuta a vedere il tuo sito / pagina come lo vede Google.

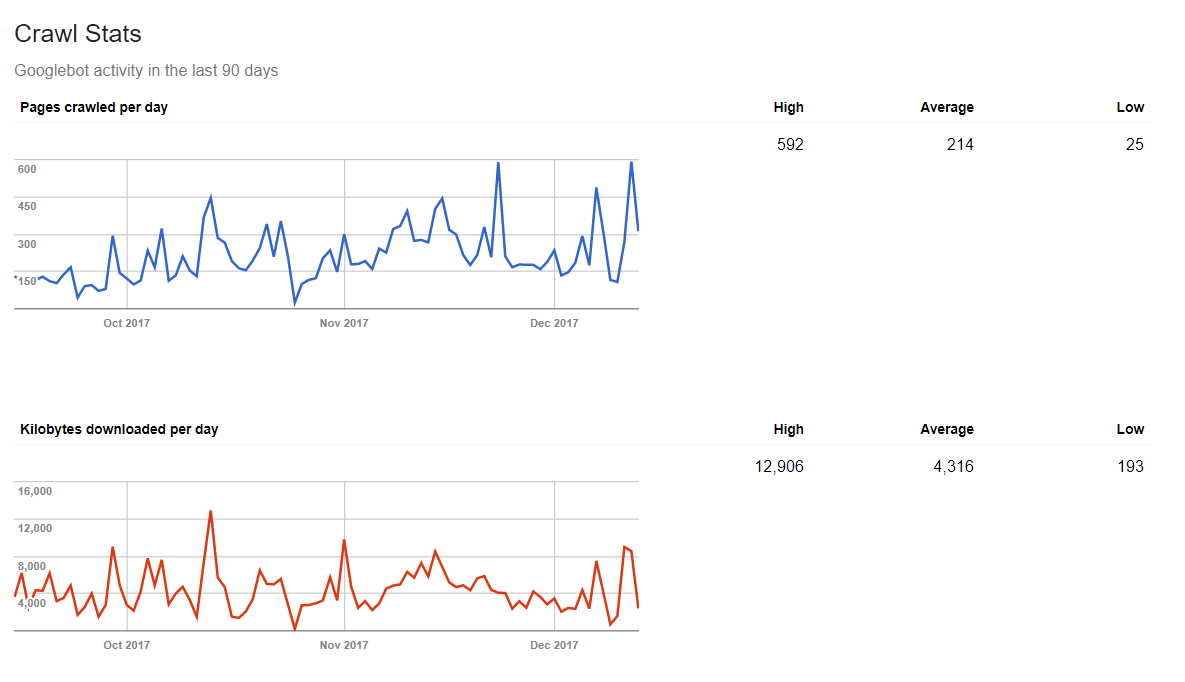

Statistiche crawling

Google può anche dirti quanti dati un spider Web elabora un giorno. Pertanto, se pubblichi regolarmente nuovi contenuti, otterrai un risultato positivo nelle statistiche.

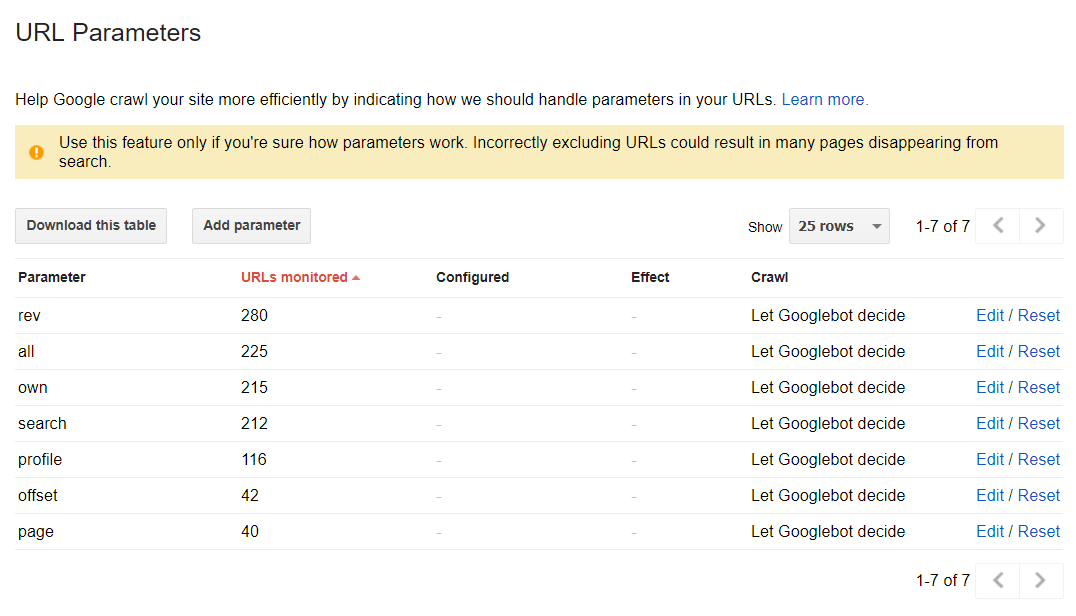

I parametri dell’URL

Questa sezione può aiutarti a scoprire in che modo Google esegue la scansione e l’indicizzazione del tuo sito web, utilizzando i parametri URL. Tuttavia, in modalità predefinita, tutte le pagine vengono sottoposte a scansione a causa delle decisioni sul Web spider: