Un archivo robots.txt es un archivo de texto colocado en sitios web para informar a los robots de los motores de búsqueda (como Google) qué páginas de ese dominio se pueden rastrear. . Si su sitio web tiene un archivo robots.txt, puede llevar a cabo una verificación con nuestra herramienta generadora de robots.txt gratuita. Puede integrar un enlace a un mapa del sitio XML en el archivo robots.txt.

Antes de que los bots de los motores de búsqueda rastreen su sitio, primero ubicarán el archivo robots.txt del sitio. Por lo tanto, verán instrucciones sobre qué páginas del sitio se pueden indexar y cuáles no deben ser indexadas por la consola del motor de búsqueda.

Con este sencillo archivo, puede configurar las opciones de rastreo e indexación para los robots de los motores de búsqueda. Y para verificar si el archivo Robots.txt está configurado en su sitio, puede utilizar nuestras herramientas gratuitas y sencillas de prueba de Robots.txt. Este artículo explicará cómo validar un archivo con la herramienta y por qué es importante usar Robots.txt Tester en su sitio.

Uso de la herramienta de comprobación de robots.txt: una guía paso a paso

Las pruebas de Robots.txt lo ayudarán a probar un archivo robots.txt en su dominio o en cualquier otro dominio que desee analizar.

La herramienta de verificación de robots.txt detectará rápidamente errores en la configuración del archivo robots.txt. Nuestra herramienta de validación es muy fácil de usar y puede ayudar incluso a un profesional o webmaster sin experiencia a verificar un archivo Robots.txt en su sitio. Obtendrá los resultadosen unos momentos.

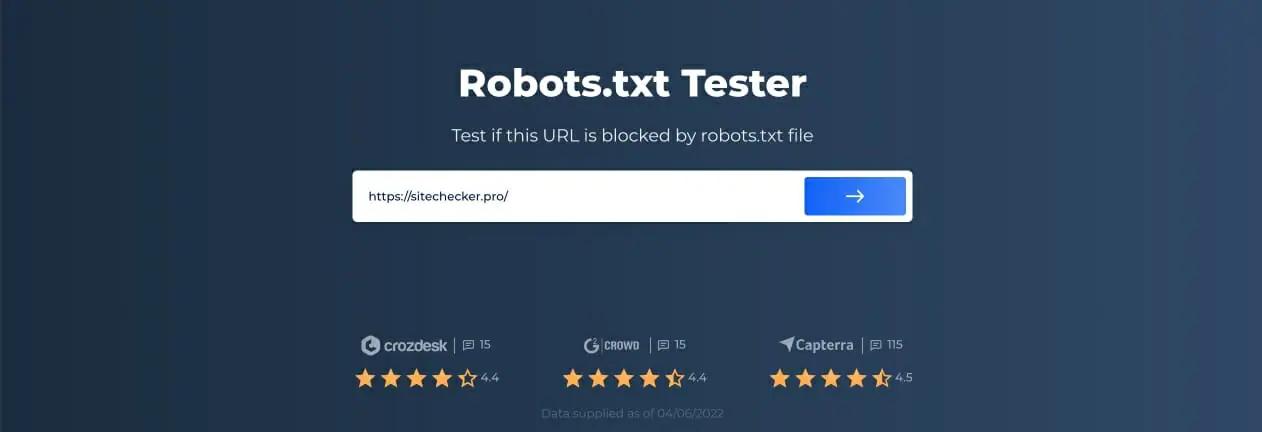

Paso 1: Inserta tu URL

Para comenzar a escanear, todo lo que tiene que hacer es ingresar la URL de interés en la línea en blanco y hacer clic en el botón de flecha azul. La herramienta comenzará a escanear y generará resultados. No es necesario registrarse en nuestro sitio web para utilizarlo.

Como ejemplo, decidimos analizar nuestro sitio web https://sitechecker.pro. En las capturas de pantalla siguientes, puede ver el proceso de escaneo en la herramienta de nuestro sitio web.

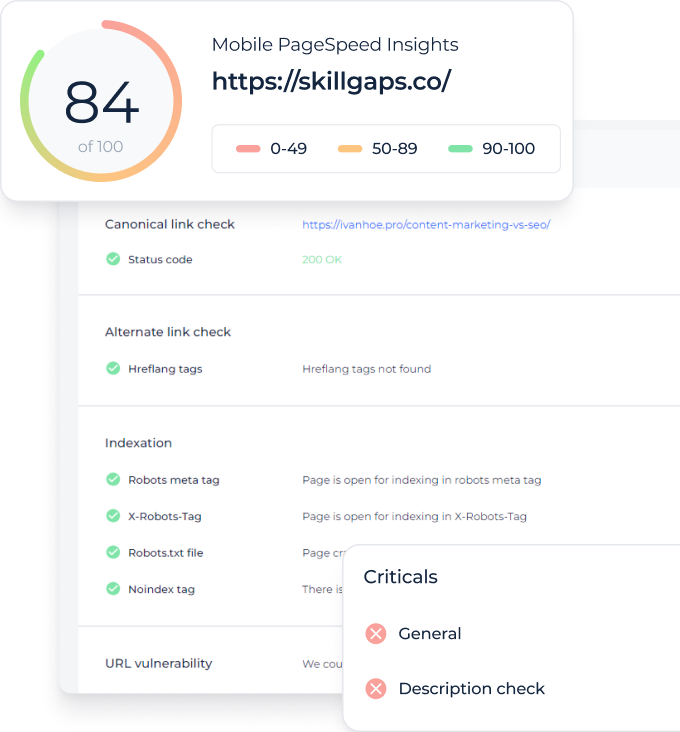

Paso 2: Interpretación de los resultados del probador de Robots.txt

Luego, cuando finalice el escaneo, verá si el archivo Robots.txt permite rastrear e indexar una página disponible en particular. Así, puedes comprobar si tu página web recibirá tráfico del buscador. Aquí también puede obtener algunos consejos de supervisión útiles.

[imagen url=”https://sitechecker.pro/wp-content/uploads/2022/04/robots-txt-tester-new-2-1.jpg” alt=”Robots.txt Tester result”]

Casos en los que se necesita Robots.txt Checker

Los problemas con el archivo robots.txt, o la falta del mismo, pueden afectar negativamente su clasificación en los motores de búsqueda. Puede perder puntos de clasificación en las SERPs. Analizar este archivo y su significado antes de rastrear su sitio web significa que puede evitar problemas con el rastreo. Además, puede evitar agregar el contenido de su sitio web a las páginas de exclusión de índice que no desea que se rastreen. Use este archivo para restringir el acceso a ciertas páginas de su sitio. Si hay un archivo vacío, puede obtener un Robots.txt not Found Issue en Rastreador SEO.

Puede crear un archivo con un editor de texto simple. Primero, especifique el agente personalizado para ejecutar la instrucción y coloque la directiva de bloqueo como disallow, noindex. Después de esto, enumere las URL que está restringiendo el rastreo. Antes de ejecutar el archivo, verifique que sea correcto. Incluso un error tipográfico puede hacer que Googlebot ignore sus instrucciones de validación.

Qué herramientas de verificación de robots.txt pueden ayudar

Cuando genera el archivo robots.txt, debe verificar si contiene algún error. Existen algunas herramientas que pueden ayudarlo a hacer frente a esta tarea.

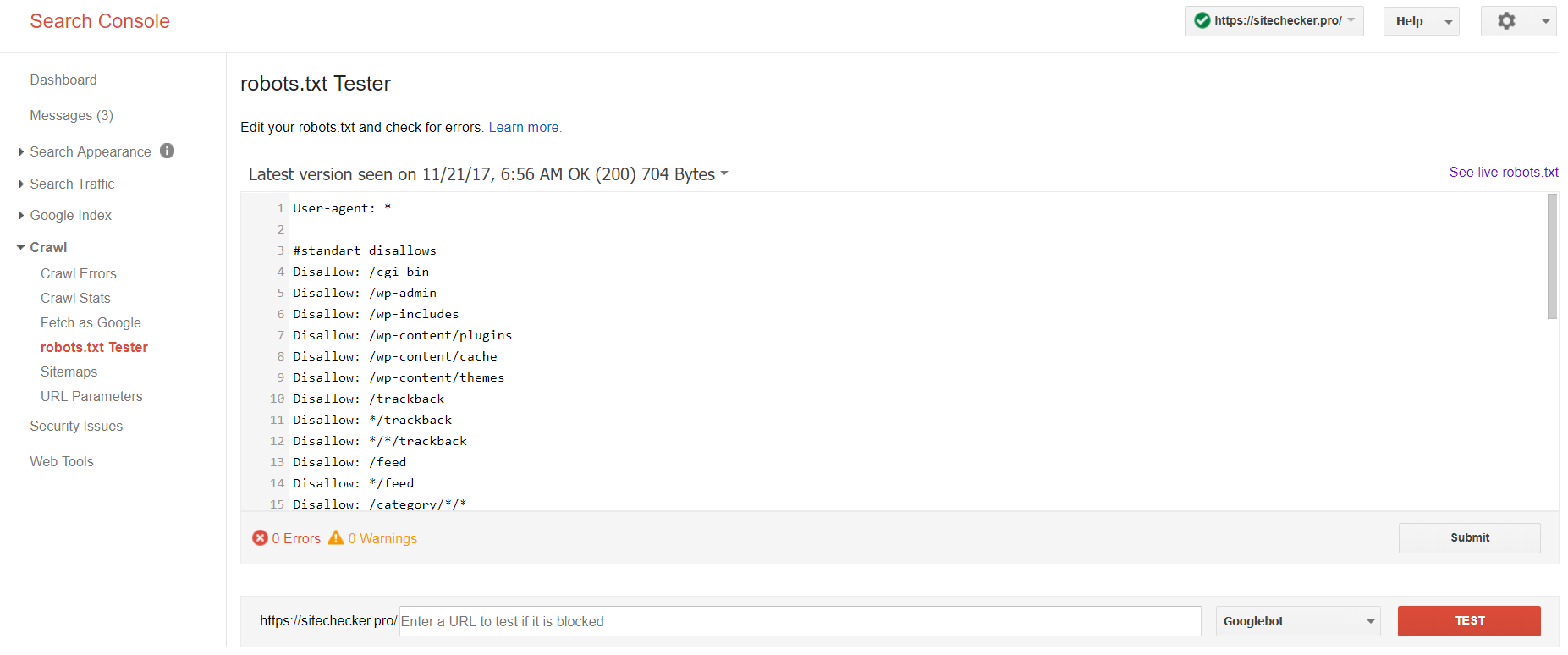

Consola de búsqueda de Google

Ahora solo la versión anterior de Google Search Console tiene una herramienta para probar el archivo de robots. Inicie sesión en la cuenta con el sitio actual confirmado en su plataforma y use esta ruta para encontrar el validador.

Versión antigua de Google Search Console > Rastreo > Probador de robots.txt

Esta prueba de robot.txt le permite:

- detectar todos sus errores y posibles problemas a la vez;

- verifique si hay errores y haga las correcciones necesarias aquí mismo para instalar el nuevo archivo en su sitio sin verificaciones adicionales;

- examinar si ha cerrado correctamente las páginas que desea evitar que se rastreen y si las que se supone que deben someterse a indexación están abiertas correctamente.

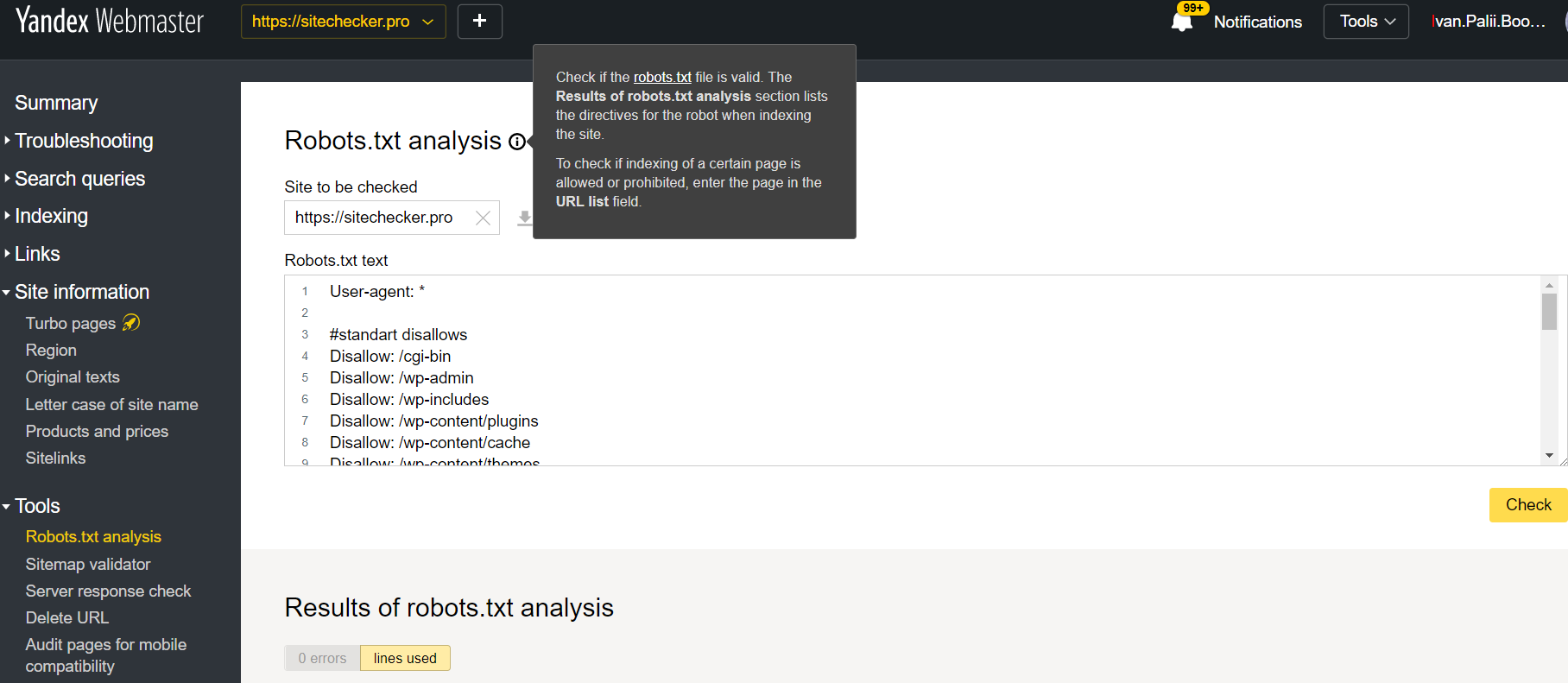

Webmaster de Yandex

Inicie sesión en la cuenta Yandex Webmaster con la confirmación del sitio actual confirmado en su plataforma y use esta ruta para encontrar la herramienta.

Webmaster de Yandex > Herramientas > Análisis de robots.txt

Este probador ofrece casi las mismas oportunidades de verificación que el descrito anteriormente. La diferencia reside en:

- aquí no necesita autorizar y probar los derechos de un sitio que ofrece una verificación inmediata de su archivo robots.txt;

- no es necesario insertar por página: la lista completa de páginas se puede comprobar en una sola sesión;

- puede asegurarse de que Yandex identificó correctamente sus instrucciones.

Rastreador del verificador de sitios

Esta es una solución para la verificación masiva si necesita rastrear un sitio web. Nuestro rastreador ayuda a auditar todo el sitio web y detecta qué URL no están permitidas en robots.txt y cuáles están cerradas para la indexación a través de la metaetiqueta noindex.

[url de la imagen=”https://sitechecker.pro/wp-content/uploads/2017/12/google-robots.txt-tester.png” alt=”google robots.txt tester”]

Preste atención: para detectar páginas no permitidas, debe rastrear el sitio web con la configuración “ignorar robots.txt”.

¡Detecte y analice no solo el archivo robots.txt sino también otro tipo de problema de SEO en su sitio!