Plik robots.txt to plik tekstowy umieszczany na stronach internetowych w celu informowania robotów wyszukiwarek (takich jak Google), które strony w tej domenie mogą być zindeksowane . Jeśli Twoja witryna zawiera plik robots.txt, możesz przeprowadzić weryfikację za pomocą naszego bezpłatnego narzędzia generatora robots.txt. Możesz zintegrować link do mapy witryny XML z plikiem robots.txt.

Zanim boty wyszukiwarek zaindeksują Twoją witrynę, najpierw zlokalizują plik robots.txt tej witryny. W ten sposób zobaczą instrukcje, które strony witryny mogą być indeksowane, a które nie powinny być indeksowane przez konsolę wyszukiwarki.

Za pomocą tego prostego pliku możesz ustawić opcje przeszukiwania i indeksowania dla robotów wyszukiwarek. Aby sprawdzić, czy plik Robots.txt jest skonfigurowany w Twojej witrynie, możesz skorzystać z naszych darmowych i prostych narzędzi testera Robots.txt. Z tego artykułu dowiesz się, jak zweryfikować plik za pomocą tego narzędzia i dlaczego ważne jest, aby używać w witrynie Tester pliku Robots.txt.

Korzystanie z narzędzia do sprawdzania pliku Robots.txt: przewodnik krok po kroku

Testowanie pliku robots.txt pomoże Ci przetestować plik robots.txt w Twojej domenie lub dowolnej innej domenie, którą chcesz przeanalizować.

Narzędzie do sprawdzania pliku robots.txt szybko wykryje błędy w ustawieniach pliku robots.txt. Nasze narzędzie do sprawdzania poprawności jest bardzo łatwe w użyciu i może pomóc nawet niedoświadczonemu profesjonaliście lub webmasterowi sprawdzić plik Robots.txt w ich witrynie. Wyniki otrzymasz w ciągu kilku chwil.

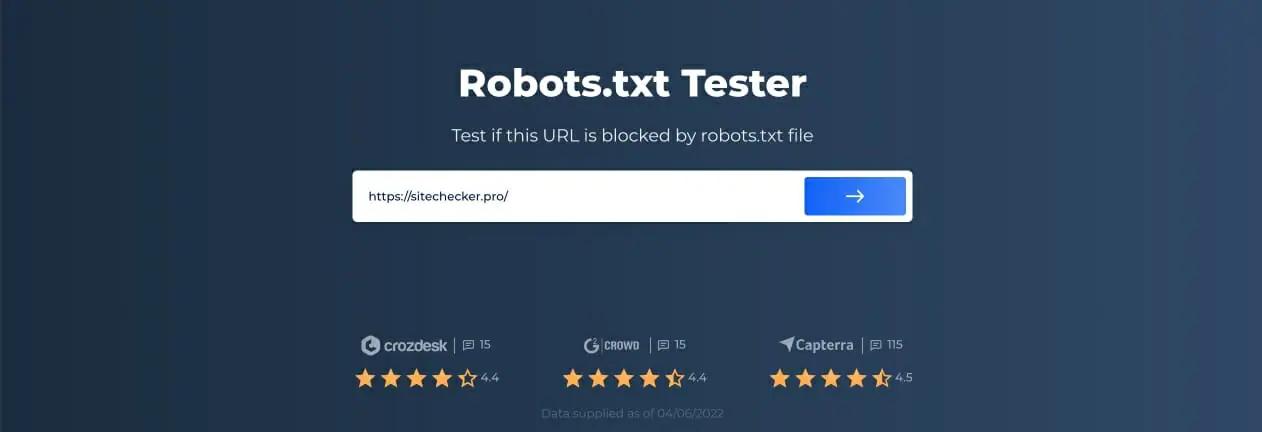

Krok 1: Wstaw swój adres URL

Aby rozpocząć skanowanie, wystarczy wpisać interesujący adres URL w pustym wierszu i kliknąć przycisk z niebieską strzałką. Narzędzie rozpocznie skanowanie i wygeneruje wyniki. Nie musisz rejestrować się na naszej stronie, aby z niej korzystać.

Jako przykład postanowiliśmy przeanalizować naszą stronę https://sitechecker.pro. Na poniższych zrzutach ekranu można zobaczyć proces skanowania w naszym narzędziu witryny.

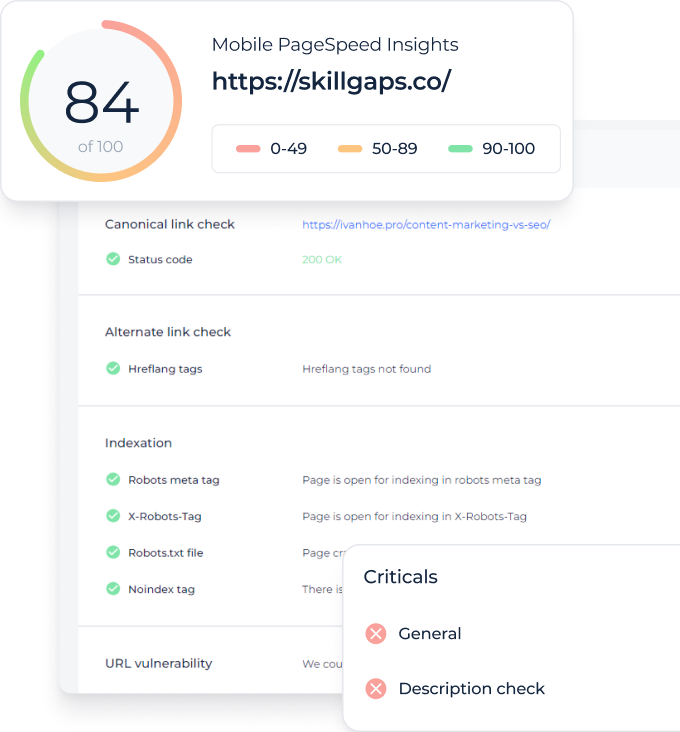

Krok 2: Interpretacja wyników testu robots.txt

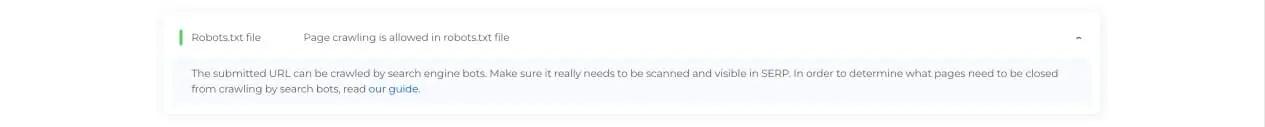

Następnie, po zakończeniu skanowania, zobaczysz, czy plik Robots.txt umożliwia przeszukiwanie i indeksowanie określonej dostępnej strony. W ten sposób możesz sprawdzić, czy Twoja strona internetowa będzie otrzymywać ruch z wyszukiwarki. Tutaj możesz również uzyskać kilka przydatnych porad dotyczących monitorowania.

Przypadki, gdy potrzebne jest narzędzie do sprawdzania pliku Robots.txt

Problemy z plikiem robots.txt lub jego brak mogą negatywnie wpłynąć na rankingi w wyszukiwarkach. Możesz stracić punkty rankingowe w SERPach. Przeanalizowanie tego pliku i jego znaczenia przed zindeksowaniem witryny oznacza, że możesz uniknąć problemów z indeksowaniem. Możesz także uniemożliwić dodawanie treści swojej witryny do stron z wykluczeniem indeksu, których nie chcesz indeksować. Użyj tego pliku, aby ograniczyć dostęp do niektórych stron w Twojej witrynie. Jeśli plik jest pusty, możesz uzyskać Problem z nieodnalezionym plikiem robots.txt w Robot SEO.

Możesz utworzyć plik za pomocą prostego edytora tekstu. Najpierw określ agenta niestandardowego do wykonania instrukcji i umieść dyrektywę blokującą, taką jak disallow, noindex. Następnie wymień adresy URL, które ograniczasz do indeksowania. Przed uruchomieniem pliku sprawdź, czy jest poprawny. Nawet literówka może spowodować, że Googlebot zignoruje Twoje instrukcje weryfikacji.

Jakie narzędzia do sprawdzania pliku robots.txt mogą pomóc

Kiedy generujesz plik robots.txt, musisz sprawdzić, czy nie zawiera on błędów. Istnieje kilka narzędzi, które mogą pomóc Ci poradzić sobie z tym zadaniem.

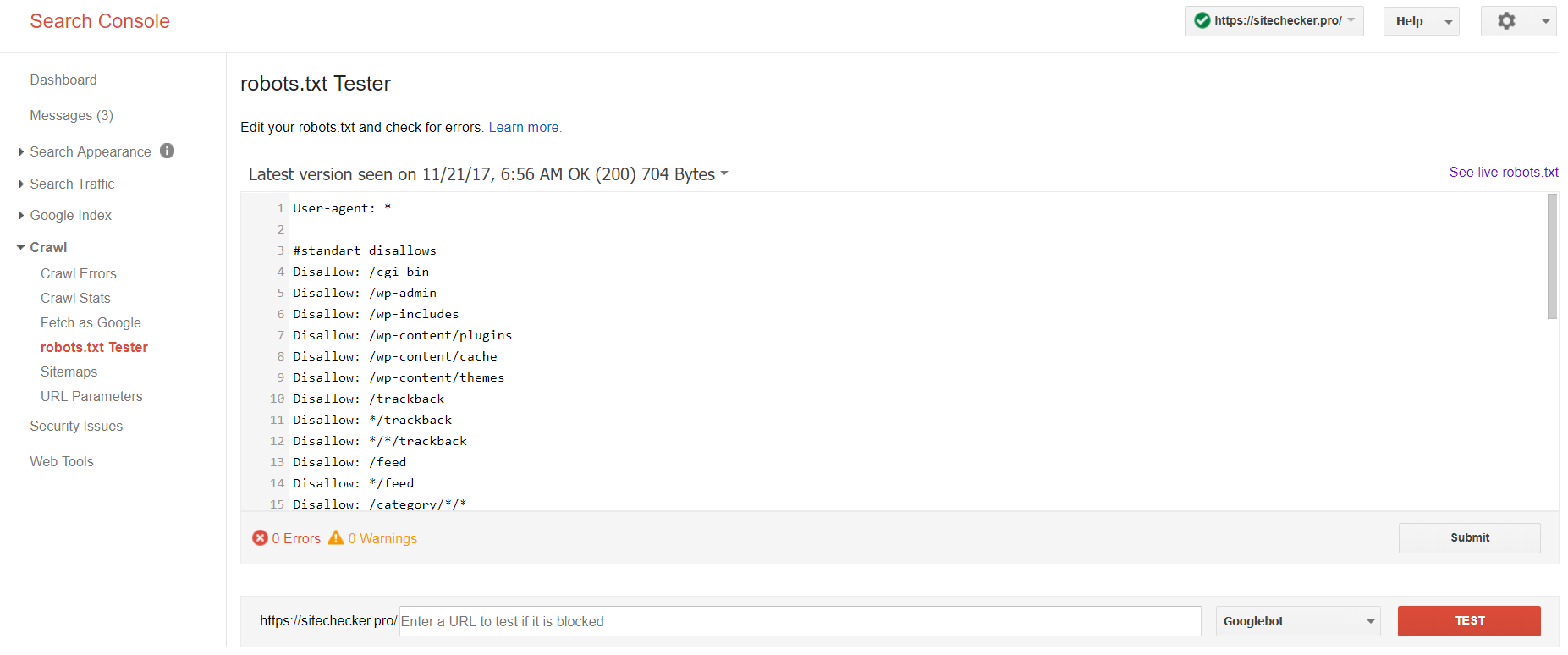

Konsola wyszukiwania Google

Teraz tylko stara wersja Google Search Console ma narzędzie do testowania pliku robotów. Zaloguj się na konto w bieżącej witrynie potwierdzonej na jej platformie i skorzystaj z tej ścieżki, aby znaleźć walidator.

Stara wersja Google Search Console > Indeksowanie > Tester pliku robots.txt

Ten test robota.txt umożliwia:

- wykryj wszystkie swoje błędy i możliwe problemy naraz;

- sprawdź błędy i wprowadź niezbędne poprawki tutaj, aby zainstalować nowy plik w swojej witrynie bez dodatkowych weryfikacji;

- sprawdź, czy odpowiednio zamknąłeś strony, których indeksowania chcesz uniknąć i czy te, które mają zostać poddane indeksacji, są odpowiednio otwarte.

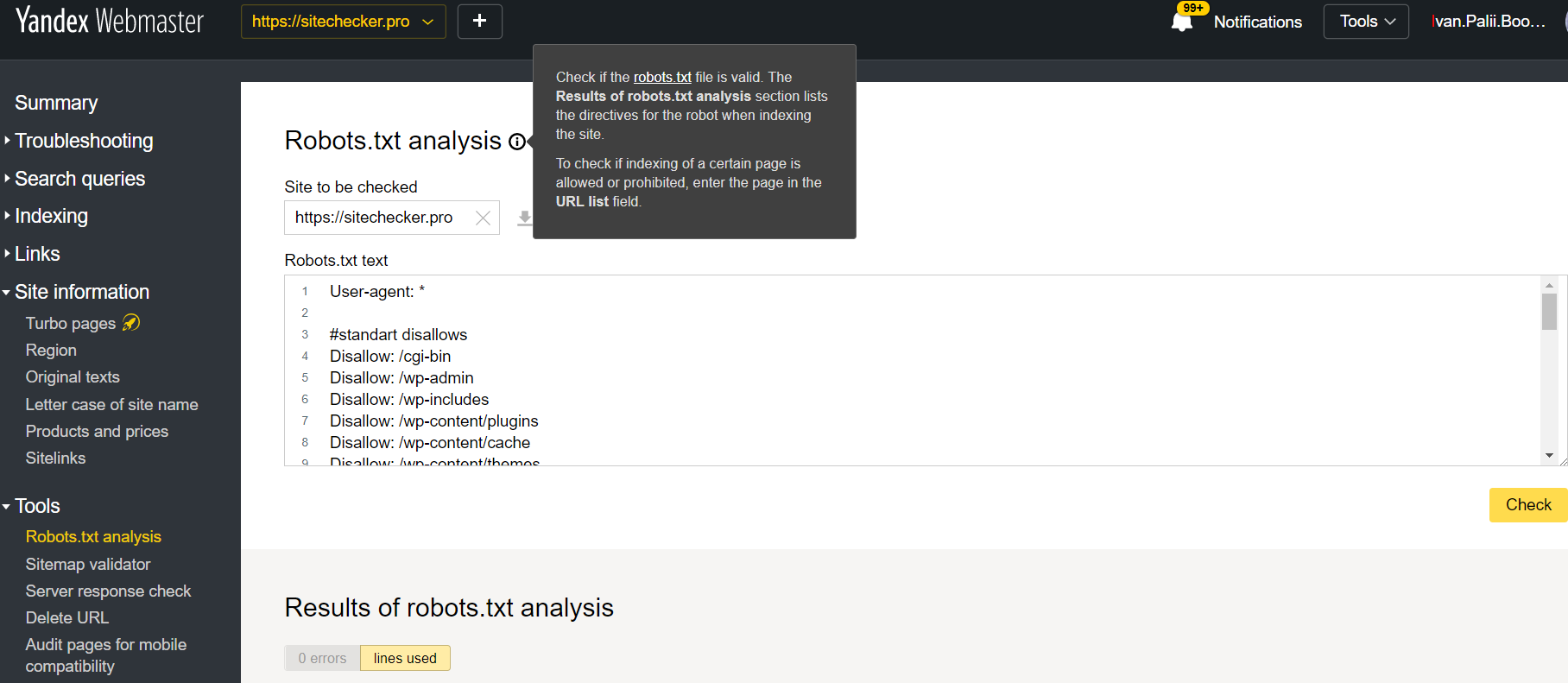

Webmaster Yandex

Zaloguj się na konto Yandex Webmaster z potwierdzeniem bieżącej witryny potwierdzone na swojej platformie i skorzystaj z tej ścieżki, aby znaleźć narzędzie.

Yandex Webmaster > Narzędzia > Analiza pliku robots.txt

Tester ten oferuje niemal równe możliwości weryfikacji, jak opisana powyżej. Różnica polega na:

- tutaj nie musisz autoryzować ani udowadniać praw do witryny, która oferuje natychmiastową weryfikację Twojego pliku robots.txt;

- nie ma potrzeby wstawiania na stronę: całą listę stron można sprawdzić w ciągu jednej sesji;

- możesz upewnić się, że Yandex prawidłowo zidentyfikował Twoje instrukcje.

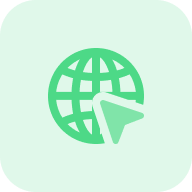

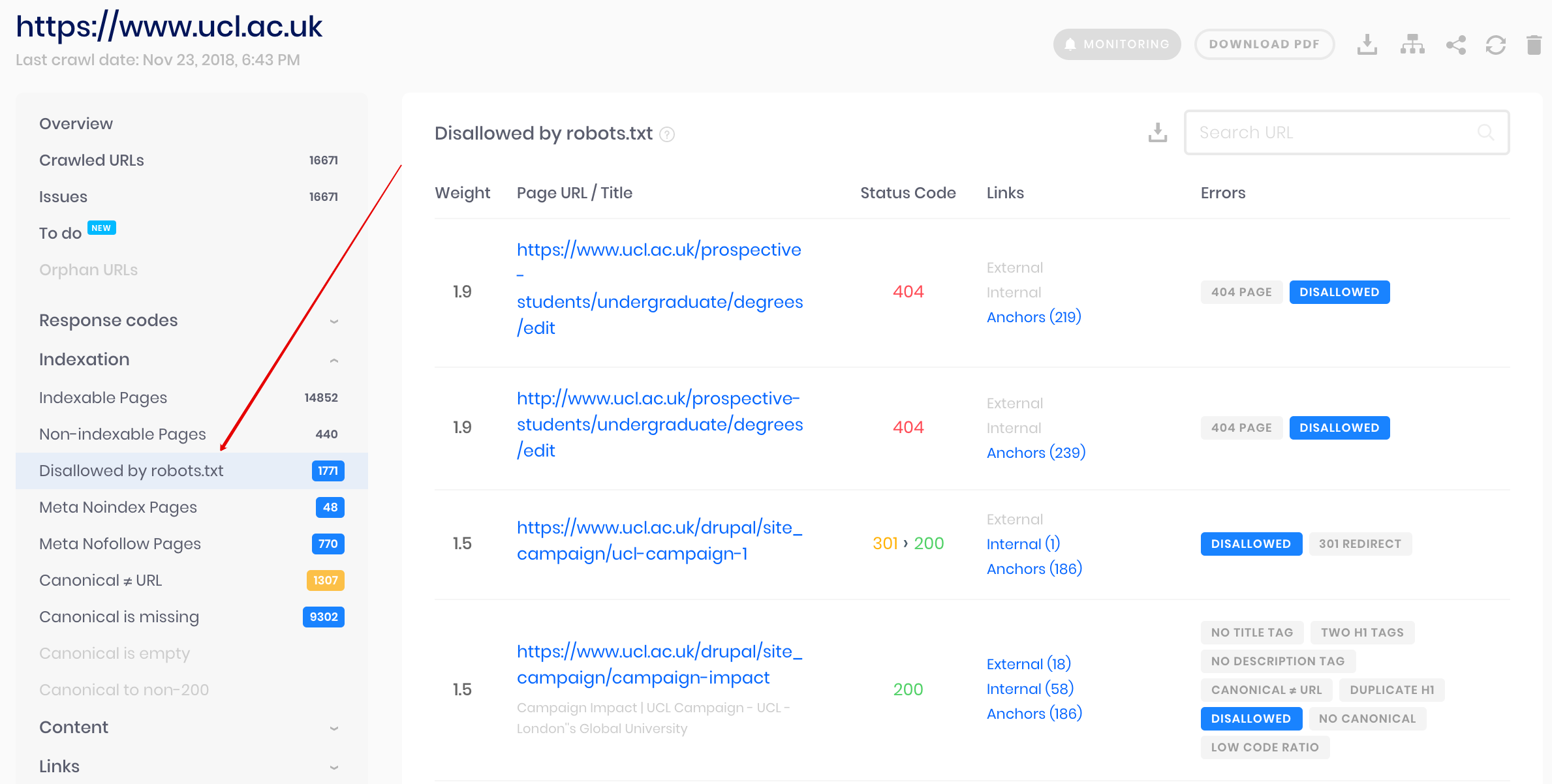

Przeszukiwarka witryny

Jest to rozwiązanie do zbiorczego sprawdzania, jeśli chcesz zindeksować witrynę. Nasz robot pomaga audytować całą witrynę i wykrywać, które adresy URL są niedozwolone w pliku robots.txt, a które są wyłączone z indeksowania za pomocą metatagu noindex.

Uwaga: aby wykryć niedozwolone strony, należy zindeksować witrynę z ustawieniem „ignoruj plik robots.txt”.

Wykryj i przeanalizuj nie tylko plik robots.txt, ale także inne problemy związane z SEO w Twojej witrynie!

Dokonaj pełnego audytu, aby znaleźć i naprawić problemy z witryną w celu poprawy wyników SERP.

Dlaczego muszę sprawdzać mój plik Robots.txt?

Robots.txt pokazuje wyszukiwarkom, które adresy URL w Twojej witrynie mogą przeszukiwać i indeksować, głównie w celu uniknięcia przeciążenia witryny zapytaniami. Sprawdzenie tego prawidłowego pliku jest zalecane w celu upewnienia się, że działa on poprawnie.