Un fichier robots.txt est un fichier texte placé sur des sites Web pour informer les robots des moteurs de recherche (comme Google) quelles pages de ce domaine peuvent être explorées . Si votre site Web contient un fichier robots.txt, vous pouvez effectuer une vérification avec notre outilgratuitgénérateur Robots.txt. Vous pouvez intégrerun lien vers un sitemap XML dans le fichier robots.txt.

Avant que les bots des moteurs de recherche n’explorent votre site, ils vont d’abord localiser le fichier robots.txt du site. Ainsi, ils verront des instructions sur les pages du site qui peuvent être indexées et celles qui ne doivent pas être indexées par la console du moteur de recherche.

Avec ce fichier simple, vous pouvez définir les options d’exploration et d’indexation pour les robots des moteurs de recherche. Et pour vérifier si le fichier Robots.txt est configuré sur votre site, vous pouvez utiliser nos outils de test Robots.txt simples et gratuits. Cet article explique comment valider un fichier avec l’outil et pourquoi il est important d’utiliser le testeur Robots.txt sur votre site.

Utilisation de l’outil de vérification Robots.txt : un guide étape par étape

Les tests Robots.txt vous aideront à tester un fichier robots.txt sur votre domaine ou tout autre domaine que vous souhaitez analyser.

L’outil de vérification robots.txt détectera rapidement les erreurs dans les paramètres du fichier robots.txt. Notre outil de validation est très facile à utiliser et peut même aider un professionnel ou un webmaster inexpérimenté à vérifier un fichier Robots.txt sur son site. Vous obtiendrez les résultats dans quelques instants.

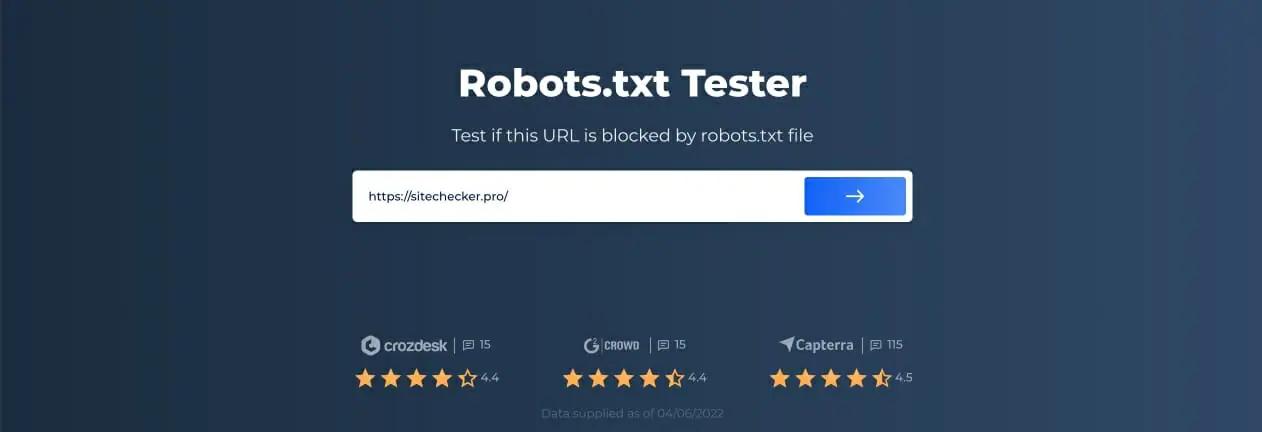

Étape 1 : Insérez votre URL

Pour lancer la numérisation, il vous suffit de saisir l’URL qui vous intéresse dans la ligne vide et de cliquer sur le bouton fléché bleu. L’outil commencera alors la numérisation et générera des résultats. Vous n’avez pas besoin de vous inscrire sur notre site Web pour l’utiliser.

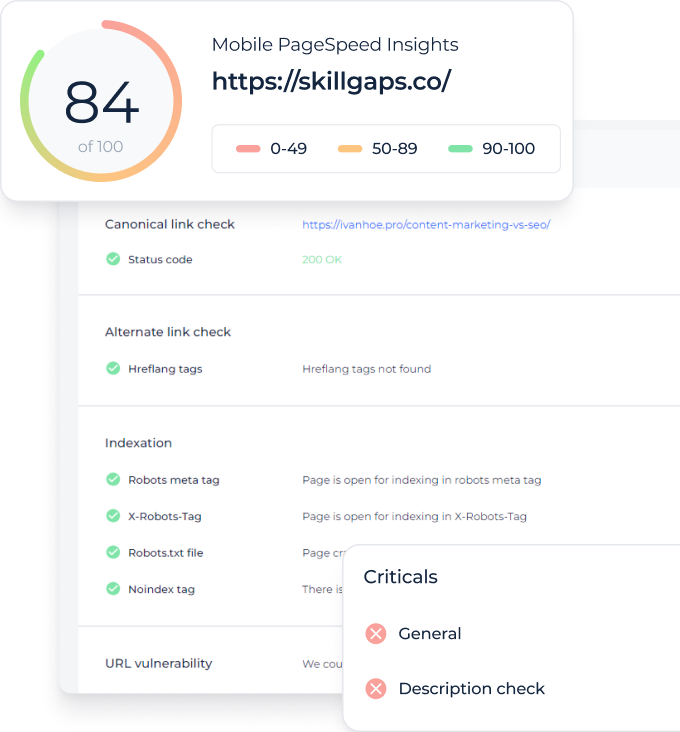

À titre d’exemple, nous avons décidé d’analysernotre site Web https://sitechecker.pro. Dans les captures d’écran ci-dessous, vous pouvez voir le processus de numérisation dans notre outil de site Web.

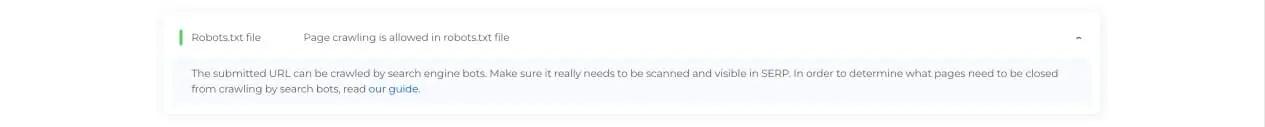

Étape 2 : Interpréter les résultats du testeur Robots.txt

Ensuite, une fois l’analyse terminée, vous verrez si le fichier Robots.txt permet l’exploration et l’indexation d’une page disponible particulière. Ainsi, vous pouvez vérifier si votre page Web recevra du trafic du moteur de recherche. Ici, vous pouvez également obtenir des conseils de surveillance utiles.

Cas où le vérificateur Robots.txt est nécessaire

Des problèmes avec le fichier robots.txt, ou son absence, peuvent affecter négativement votre classement dans les moteurs de recherche. Vous risquez de perdre des points de classement dans les SERPs. L’analyse de ce fichier et de sa signification avant d’explorer votre site Web signifie que vous pouvez éviter les problèmes d’exploration. En outre, vous pouvez empêcher l’ajout du contenu de votre site Web aux pages d’exclusion d’index que vous ne souhaitez pas voir explorées. Utilisez ce fichier pour restreindre l’accès à certaines pages de votre site. S’il y a un fichier vide, vous pouvez obtenir un Problème Robots.txt introuvable dans SEO-crawler.

Vous pouvez créer un fichier avec un simple éditeur de texte. Tout d’abord, spécifiez l’agent personnalisé pour exécuter l’instruction et placez la directive de blocage comme disallow, noindex. Ensuite, répertoriez les URL dont vous restreignez l’exploration. Avant d’exécuter le fichier, vérifiez qu’il est correct. Même une faute de frappe peut amener Googlebot à ignorer vos instructions de validation.

Ce que les outils de vérification de robots.txt peuvent aider

Lorsque vous générez un fichier robots.txt, vous devez vérifier s’il contient des erreurs. Il existe quelques outils qui peuvent vous aider à faire face à cette tâche.

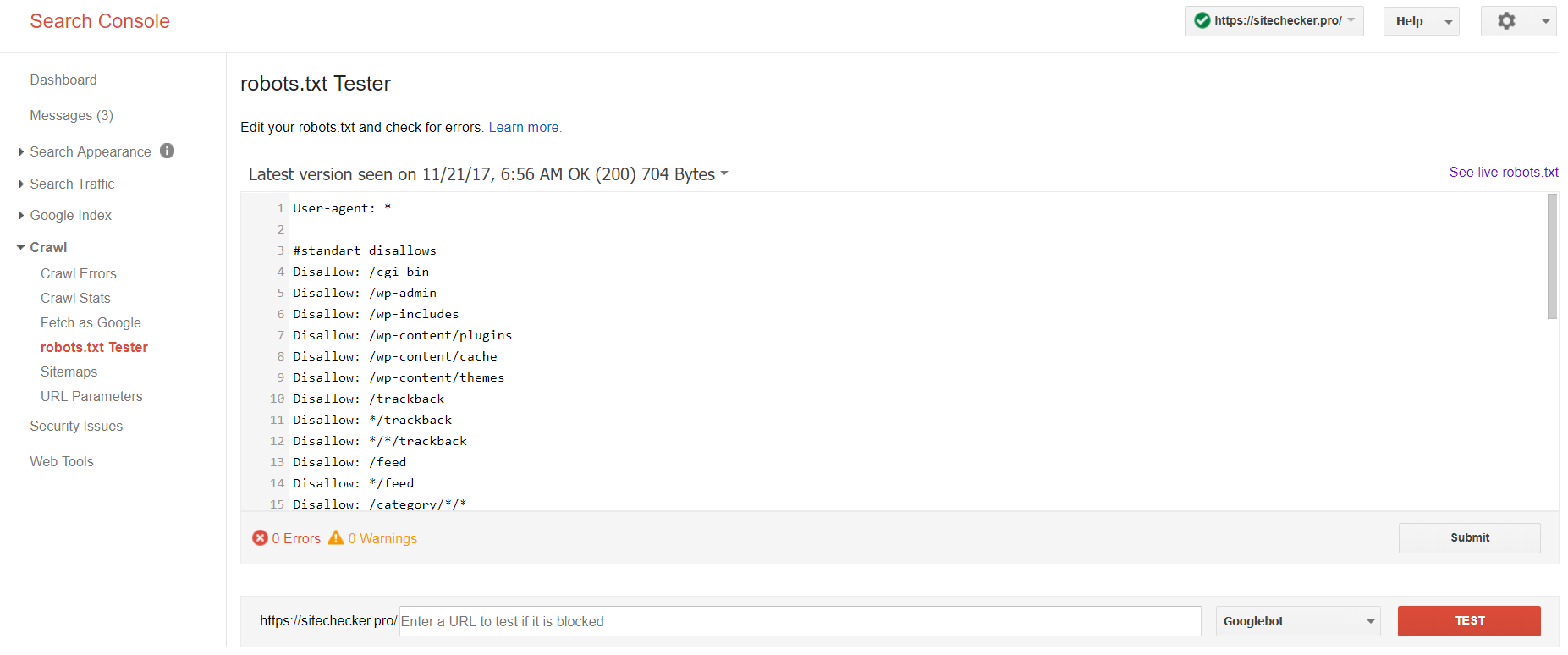

Console de recherche Google

Désormais, seule l’ancienne version de Google Search Console dispose d’un outil pour tester le fichier des robots. Connectez-vous au compte avec le site actuel confirmé sur sa plateforme et utilisez ce chemin pour trouver un validateur.

Ancienne version de Google Search Console > Explorer > ; Testeur robots.txt

Ce test robot.txt vous permet de :

- détecter toutes vos erreurs et problèmes éventuels en même temps ;

- vérifiez les erreurs et apportez les corrections nécessaires ici pour installer le nouveau fichier sur votre site sans aucune vérification supplémentaire ;

- vérifiez si vous avez correctement fermé les pages que vous souhaitez éviter d’explorer et si celles qui sont censées subir une indexation sont correctement ouvertes.

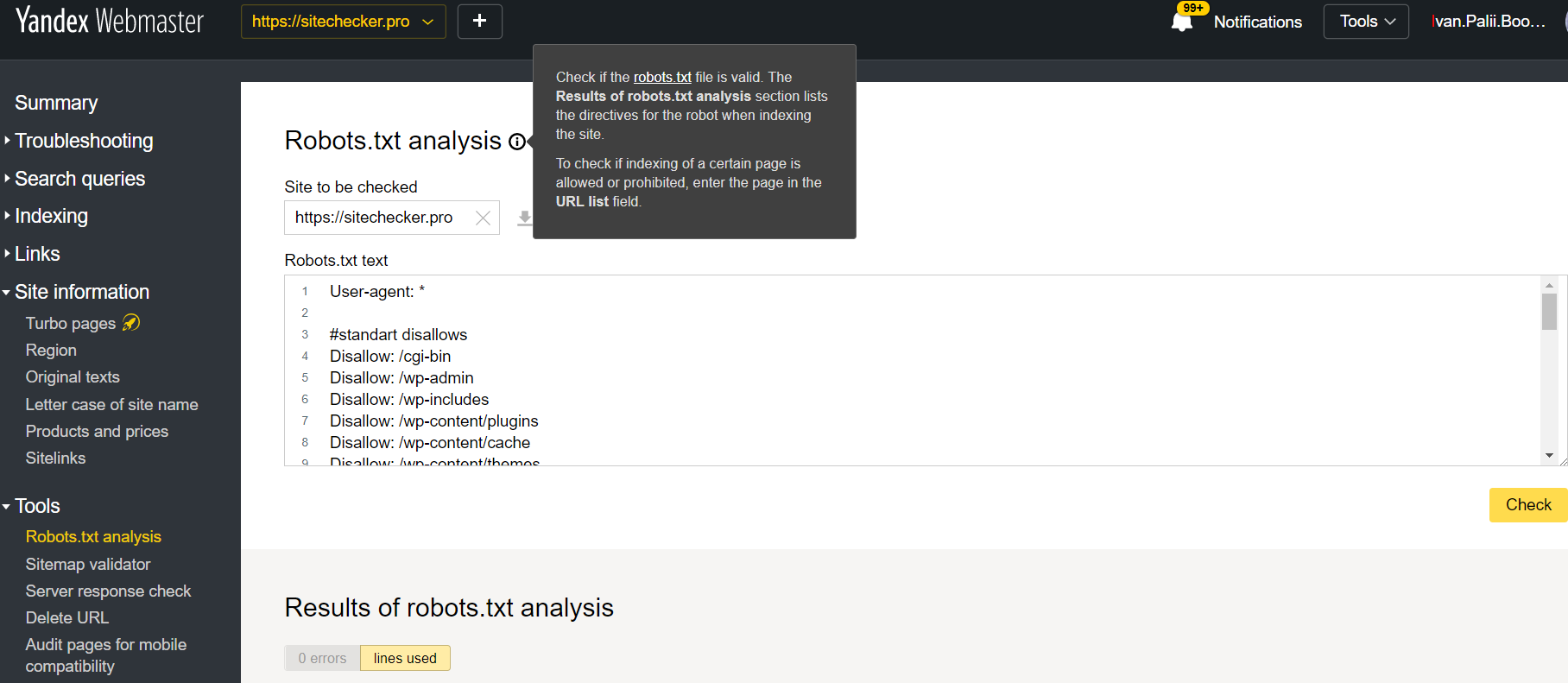

Webmestre Yandex

Connectez-vous au compte Yandex Webmaster avec la confirmation du site actuel confirmé sur sa plate-forme et utilisez ce chemin pour trouver l’outil.

Webmestre Yandex > Outils > Analyse robots.txt

Ce testeur offre des possibilités de vérification presque égales à celles décrites ci-dessus. La différence réside dans :

- ici, vous n’avez pas besoin d’autoriser et de prouver les droits pour un site qui offre une vérification immédiate de votre fichier robots.txt ;

- il n’est pas nécessaire d’insérer par page : la liste complète des pages peut être vérifiée en une seule session ;

- vous pouvez vous assurer que Yandex a correctement identifié vos instructions.

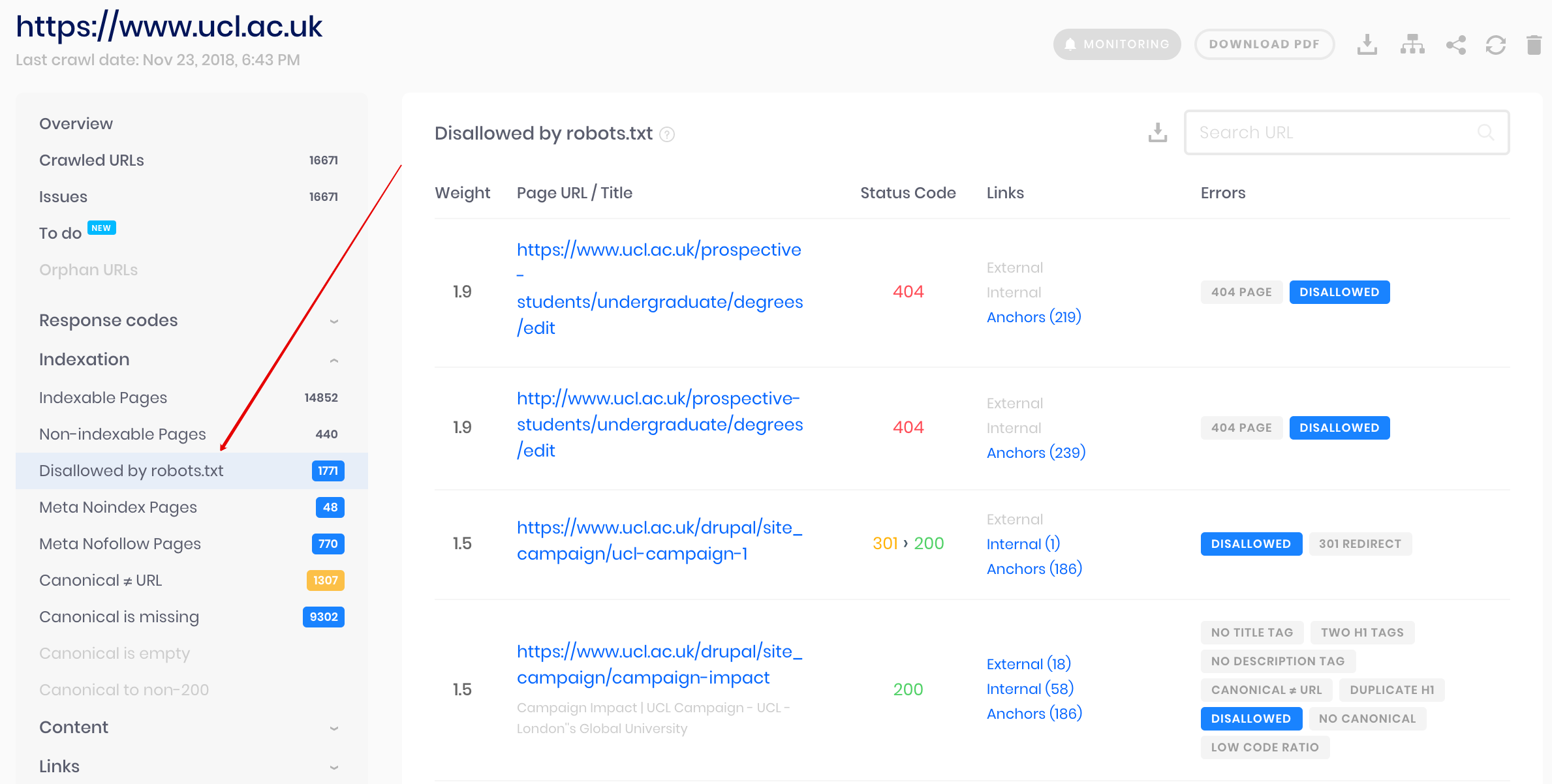

Crawler Sitechecker

Il s’agit d’une solution de vérification groupée si vous avez besoin d’explorer un site Web. Notre robot d’exploration aide à auditer l’ensemble du site Web et à détecter quelles URL sont interdites dans robots.txt et lesquelles d’entre elles sont fermées à l’indexation via la balise meta noindex.

Attention : pour détecter les pages non autorisées, vous devez explorer le site Web avec le paramètre “ignorer le fichier robots.txt”.

Détectez et analysez non seulement le fichier robots.txt, mais également d'autres types de problèmes de référencement sur votre site !

Faites un audit complet pour découvrir et résoudre les problèmes de votre site Web afin d'améliorer vos résultats SERP.

Pourquoi ai-je besoin de vérifier mon fichier Robots.txt ?

Robots.txt indique aux moteurs de recherche les URL de votre site qu'ils peuvent explorer et indexer, principalement pour éviter de surcharger votre site de requêtes. Il est recommandé de vérifier ce fichier valide pour s'assurer qu'il fonctionne correctement.