Eine robots.txt-Datei ist eine Textdatei, die auf Websites platziert wird, um Suchmaschinenroboter (wie Google) darüber zu informieren, welche Seiten auf dieser Domain gecrawlt werden können . Wenn Ihre Website über eine robots.txt-Datei verfügt, können Sie die Verifizierung mit unserem kostenlosen Robots.txt-Generator-Tool durchführen. Sie können einen Link zu einer XML-Sitemap in die robots.txt-Datei integrieren.

Bevor Suchmaschinen-Bots Ihre Website crawlen, suchen sie zuerst die robots.txt-Datei der Website. Daher werden ihnen Anweisungen angezeigt, welche Seiten der Website von der Suchmaschinenkonsole indiziert werden können und welche nicht indiziert werden sollten.

Mit dieser einfachen Datei können Sie Crawling- und Indizierungsoptionen für Suchmaschinen-Bots festlegen. Und um zu prüfen, ob die Robots.txt-Datei auf Ihrer Website konfiguriert ist, Sie können unsere kostenlosen und einfachen Robots.txt-Tester-Tools verwenden. In diesem Artikel wird erläutert, wie Sie eine Datei mit dem Tool validieren und warum es wichtig ist, Robots.txt Tester auf Ihrer Website zu verwenden.

Verwendung des Robots.txt Checker Tools: Eine Schritt-für-Schritt-Anleitung

Robots.txt-Tests helfen Ihnen, eine robots.txt-Datei auf Ihrer Domain oder einer anderen Domain, die Sie analysieren möchten, zu testen.

Das robots.txt-Prüftool erkennt schnell Fehler in den Einstellungen der robots.txt-Datei. Unser Validator-Tool ist sehr einfach zu verwenden und kann sogar unerfahrenen Fachleuten oder Webmastern helfen, eine Robots.txt-Datei auf ihrer Website zu überprüfen. Sie erhalten die Ergebnisse in wenigen Augenblicken.

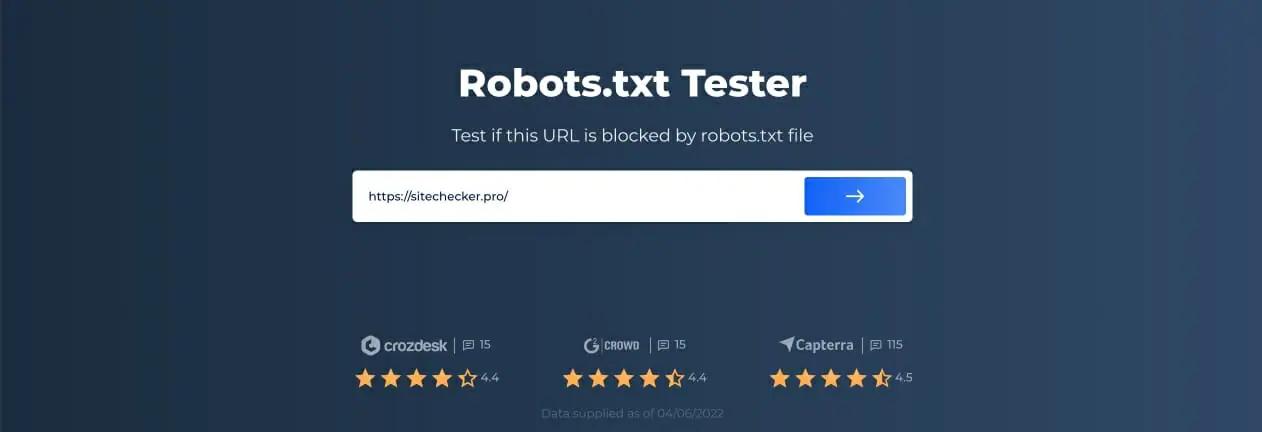

Schritt 1: Geben Sie Ihre URL ein

Um mit dem Scannen zu beginnen, müssen Sie lediglich die gewünschte URL in die leere Zeile eingeben und auf die Schaltfläche mit dem blauen Pfeil klicken. Das Tool beginnt dann mit dem Scannen und generiert Ergebnisse. Sie müssen sich auf unserer Website nicht registrieren, um sie zu nutzen.

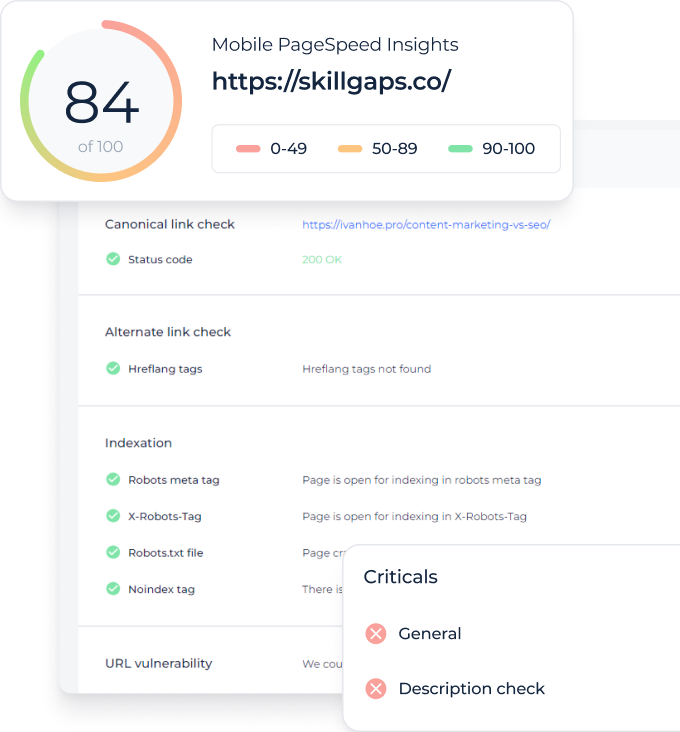

Als Beispiel haben wir uns entschieden, unsere Website https://sitechecker.pro zu analysieren. In den Screenshots unten sehen Sie den Scanvorgang in unserem Website-Tool.

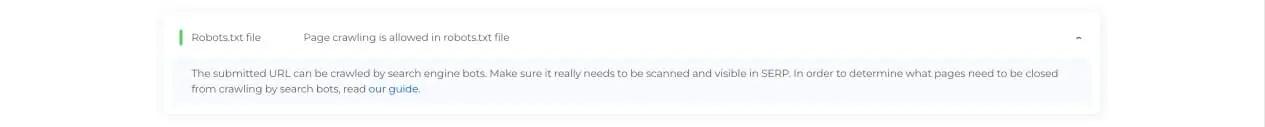

Schritt 2: Interpretieren der Ergebnisse des Robots.txt-Testers

Als Nächstes sehen Sie nach Abschluss des Scans, ob die Robots.txt-Datei das Crawlen und Indizieren einer bestimmten verfügbaren Seite zulässt. So können Sie prüfen, ob Ihre Webseite Traffic von der Suchmaschine erhält. Hier erhalten Sie auch einige nützliche Überwachungshinweise.

Fälle, in denen Robots.txt Checker benötigt wird

Probleme mit der robots.txt-Datei oder deren Fehlen können sich negativ auf Ihre Suchmaschinen-Rankings auswirken. Sie können Ranking-Punkte in den SERPs verlieren. Durch Analysieren dieser Datei und ihrer Bedeutung vor dem Crawlen Ihrer Website können Sie Probleme beim Crawling vermeiden. Außerdem können Sie verhindern, dass Inhalte Ihrer Website zu den Index-Ausschlussseiten hinzugefügt werden, die nicht gecrawlt werden sollen. Verwenden Sie diese Datei, um den Zugriff auf bestimmte Seiten Ihrer Website einzuschränken. Wenn eine leere Datei vorhanden ist, können Sie ein Problem „Robots.txt nicht gefunden“ erhalten SEO-Crawler.

Sie können eine Datei mit einem einfachen Texteditor erstellen. Geben Sie zunächst den benutzerdefinierten Agenten an, um die Anweisung auszuführen, und platzieren Sie die Blockierungsdirektive wie disallow, noindex. Listen Sie danach die URLs auf, für die Sie das Crawling einschränken. Überprüfen Sie vor dem Ausführen der Datei, ob sie korrekt ist. Selbst ein Tippfehler kann dazu führen, dass der Googlebot Ihre Anleitung zur Validierung ignoriert.

Welche robots.txt-Prüftools helfen können

Wenn Sie eine robots.txt-Datei generieren, müssen Sie überprüfen, ob sie Fehler enthält. Es gibt einige Tools, die Ihnen bei der Bewältigung dieser Aufgabe helfen können.

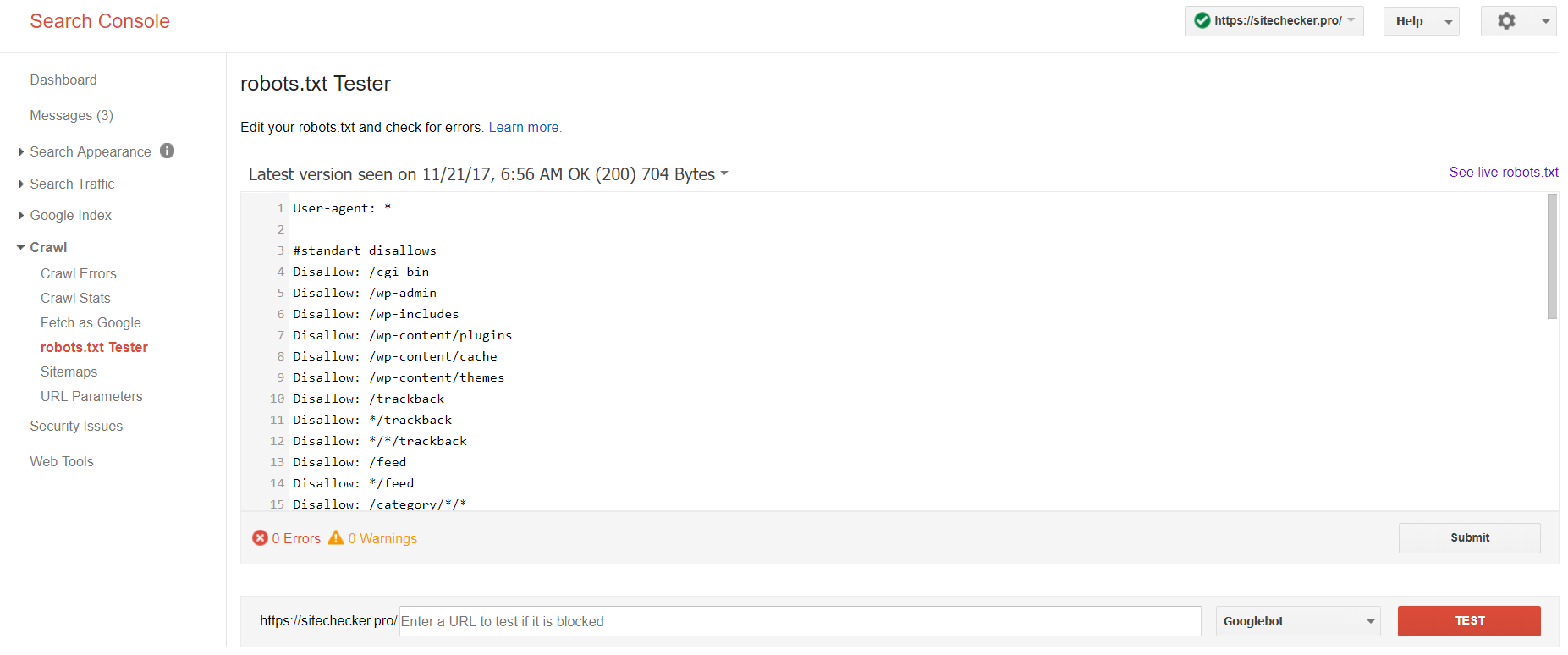

Google Search Console

Jetzt verfügt nur die alte Version von Google Search Console über ein Tool zum Testen von Robots-Dateien. Melden Sie sich bei einem Konto mit der aktuellen Website an, die auf ihrer Plattform bestätigt wurde, und verwenden Sie diesen Pfad, um den Validator zu finden.

Alte Version der Google Search Console > Crawlen > Robots.txt-Tester

Mit diesem robot.txt-Test können Sie:

- alle Ihre Fehler und möglichen Probleme sofort erkennen;

- Suchen Sie nach Fehlern und nehmen Sie die erforderlichen Korrekturen direkt hier vor, um die neue Datei ohne zusätzliche Überprüfungen auf Ihrer Website zu installieren;

- überprüfen Sie, ob Sie die Seiten, die Sie nicht crawlen möchten, ordnungsgemäß geschlossen haben und ob diejenigen, die indexiert werden sollen, ordnungsgemäß geöffnet sind.

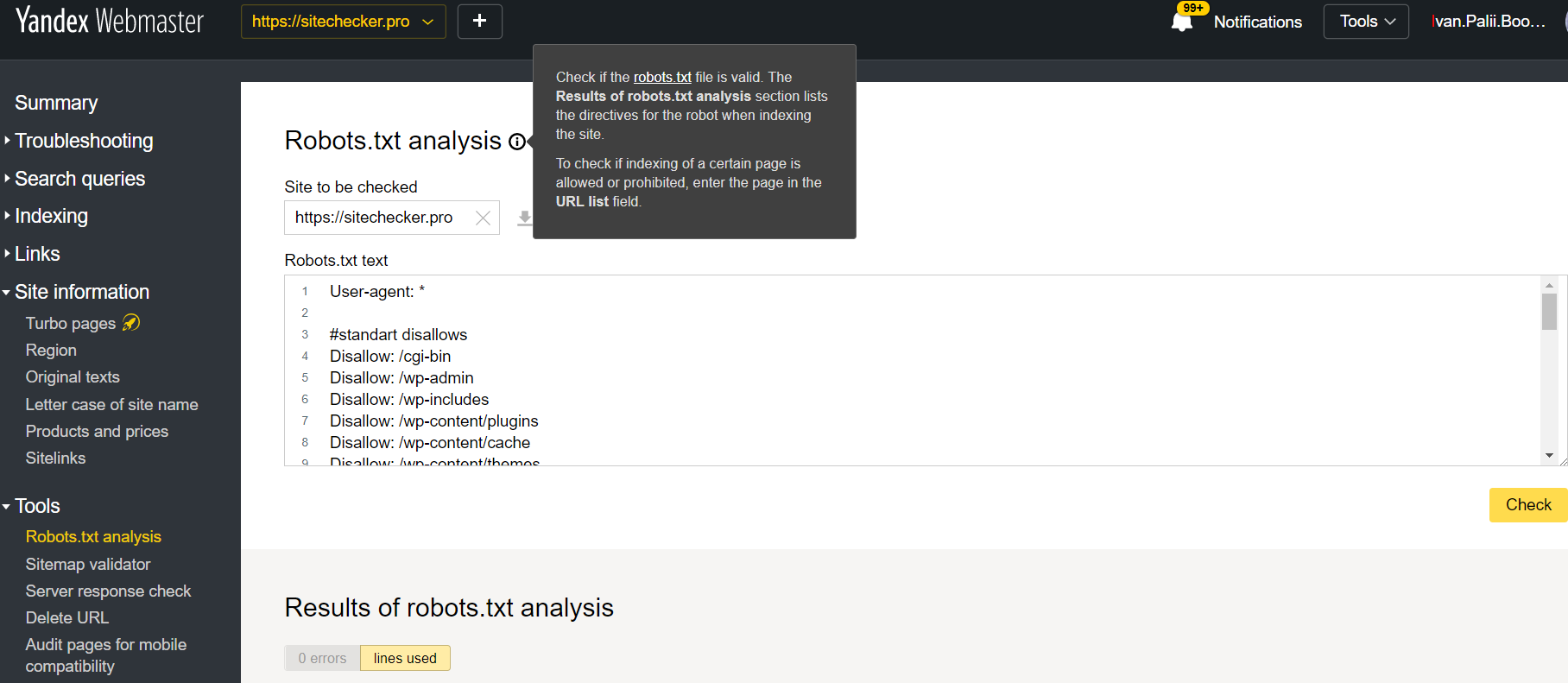

Yandex-Webmaster

Melden Sie sich beim Yandex Webmaster-Konto an und bestätigen Sie die aktuelle Website auf seiner Plattform bestätigt und verwenden Sie diesen Pfad, um das Tool zu finden.

Yandex-Webmaster > Werkzeuge > Robots.txt-Analyse

Dieser Tester bietet fast die gleichen Überprüfungsmöglichkeiten wie der oben beschriebene. Der Unterschied liegt in:

- Hier müssen Sie keine Rechte für eine Website autorisieren und nachweisen, die eine sofortige Überprüfung Ihrer robots.txt-Datei anbietet;

- Einfügen pro Seite ist nicht erforderlich: Die gesamte Seitenliste kann in einer Sitzung überprüft werden;

- Sie können sicherstellen, dass Yandex Ihre Anweisungen richtig identifiziert hat.

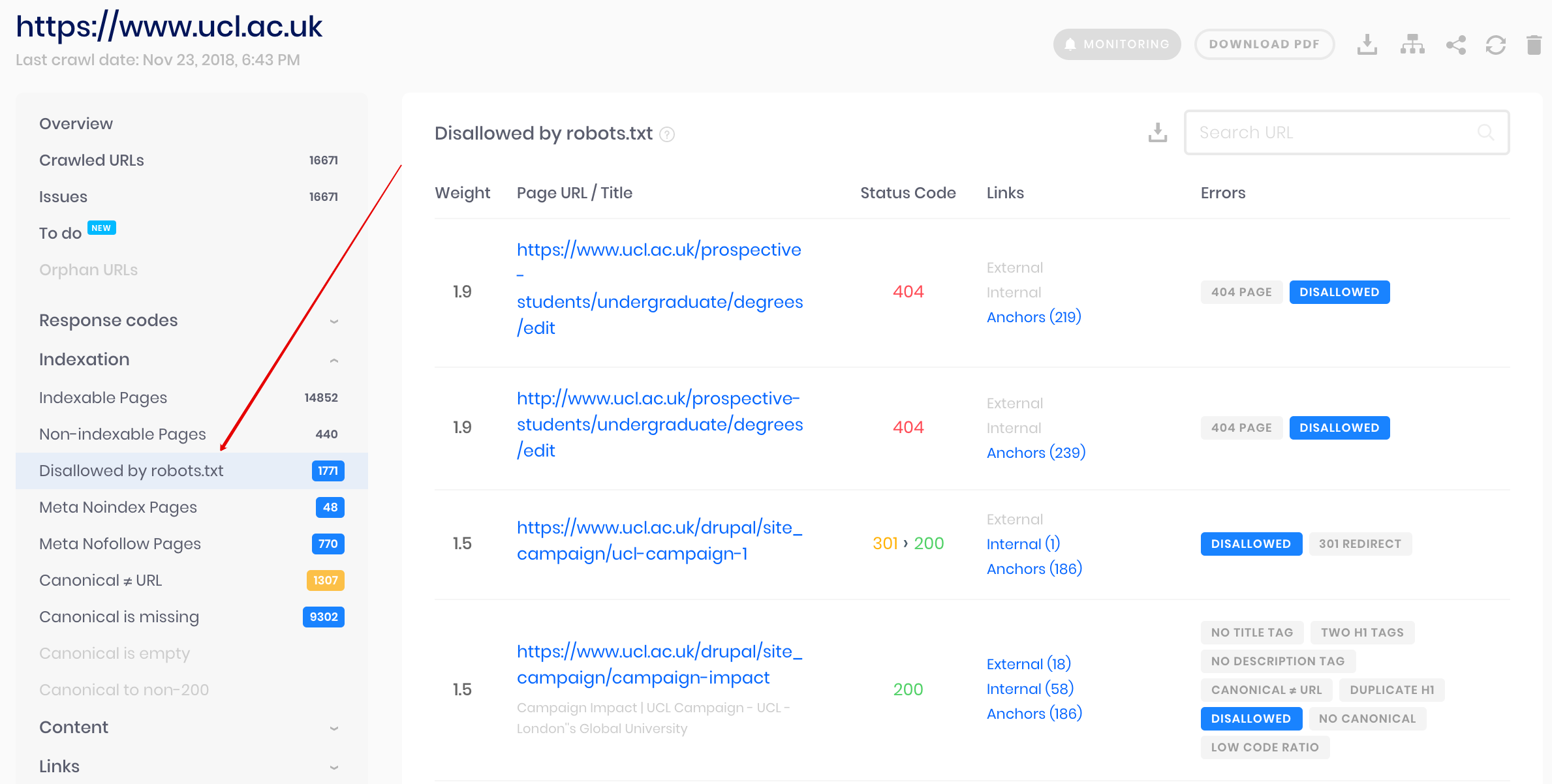

Sitechecker-Crawler

Dies ist eine Lösung für Massenprüfungen, wenn Sie Websites crawlen müssen. Unser Crawler hilft dabei, die gesamte Website zu prüfen und zu erkennen, welche URLs in der robots.txt-Datei nicht zugelassen sind und welche von der Indexierung über das noindex-Meta-Tag ausgeschlossen sind.

Achtung: Um unzulässige Seiten zu erkennen, sollten Sie die Website mit der Einstellung „ignore robots.txt“ crawlen.

Erkennen und analysieren Sie nicht nur die robots.txt-Datei, sondern auch andere Arten von SEO-Problemen auf Ihrer Website!

Führen Sie ein vollständiges Audit durch, um Ihre Website-Probleme herauszufinden und zu beheben, um Ihre SERP-Ergebnisse zu verbessern.

Warum muss ich meine Robots.txt-Datei überprüfen?

Robots.txt zeigt Suchmaschinen, welche URLs auf Ihrer Website sie crawlen und indizieren können, hauptsächlich um eine Überlastung Ihrer Website mit Abfragen zu vermeiden. Es wird empfohlen, diese gültige Datei zu überprüfen, um sicherzustellen, dass sie korrekt funktioniert.