Bir robots.txt dosyası, arama motoru robotlarına (Google gibi) o alan adındaki hangi sayfaların taranabileceğini bildirmek için web sitelerine yerleştirilen bir metin dosyasıdır. . Web sitenizde bir robots.txt dosyası varsa, ücretsiz Robots.txt oluşturucu aracımız ile doğrulama gerçekleştirebilirsiniz. Bir XML site haritasının bağlantısını robots.txt dosyasına entegre edebilirsiniz .

Arama motoru botları sitenizi taramadan önce, sitenin robots.txt dosyasını bulurlar. Böylece, hangi site sayfalarının dizine eklenebileceğine ve hangilerinin arama motoru konsolu tarafından dizine eklenmeyeceğine ilişkin talimatları göreceklerdir.

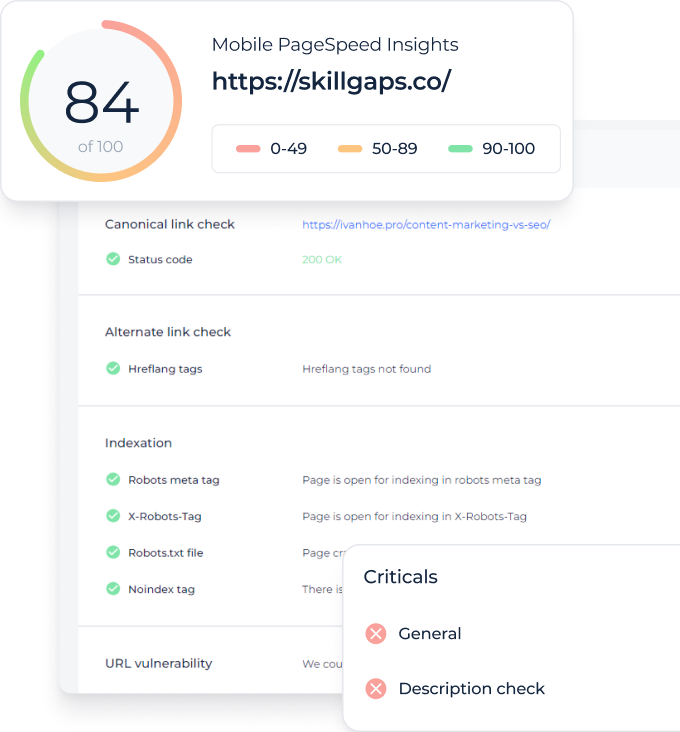

Bu basit dosya ile arama motoru botları için tarama ve indeksleme seçeneklerini ayarlayabilirsiniz. Ve sitenizde Robots.txt dosyasının yapılandırılıp yapılandırılmadığını kontrol etmek için, ücretsiz ve basit Robots.txt Tester araçlarımızı kullanabilirsiniz. Bu makale, araçla bir dosyanın nasıl doğrulanacağını ve sitenizde Robots.txt Tester kullanmanın neden önemli olduğunu açıklayacaktır.

Robots.txt Denetleyici Aracı Kullanımı: Adım Adım Kılavuz

Robots.txt testi, bir robots.txt dosyasını alanınızda veya analiz etmek istediğiniz başka herhangi bir alanda test etmenize yardımcı olacaktır.

robots.txt kontrol aracı, robots.txt dosya ayarlarındaki hataları hızlı bir şekilde algılar . Doğrulama aracımızın kullanımı çok kolaydır ve deneyimsiz bir profesyonelin veya web yöneticisinin bile sitelerindeki bir Robots.txt dosyasını kontrol etmesine yardımcı olabilir. Sonuçları birkaç dakika içinde alacaksınız.

1. Adım: URL’nizi girin

Taramaya başlamak için tek yapmanız gereken boş satıra ilgilenilen URL’yi girmek ve mavi ok düğmesine tıklamaktır. Araç daha sonra taramaya başlayacak ve sonuçlar üretecektir. Kullanmak için sitemize üye olmanıza gerek yoktur.

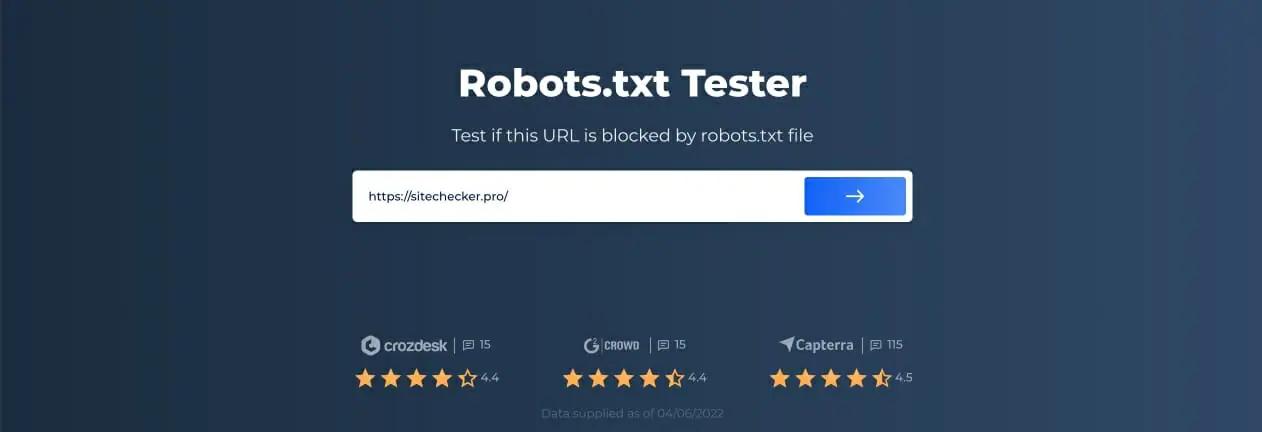

Örnek olarak, https://sitechecker.pro web sitemizi analiz etmeye karar verdik. Aşağıdaki ekran görüntülerinde, web sitesi aracımızdaki tarama işlemini görebilirsiniz.

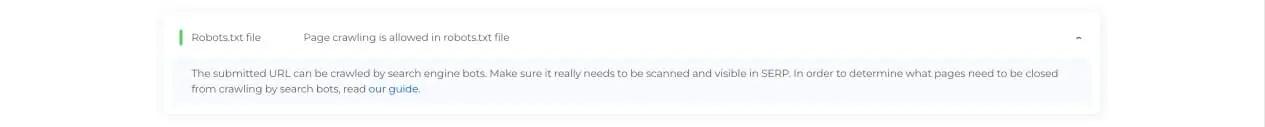

2. Adım: Robots.txt Test Cihazı Sonuçlarını Yorumlama

Ardından, tarama bittiğinde, Robots.txt dosyasının belirli bir kullanılabilir sayfanın taranmasına ve dizine eklenmesine izin verip vermediğini göreceksiniz. Böylece, web sayfanızın arama motorundan trafik alıp almayacağını kontrol edebilirsiniz. Burada ayrıca bazı faydalı izleme tavsiyeleri de alabilirsiniz.

Robots.txt Denetleyicisinin Gerekli Olduğu Durumlar

Robots.txt dosyasıyla ilgili sorunlar veya dosyanın olmaması, arama motoru sıralamalarınızı olumsuz etkileyebilir. SERP’lerde sıralama puanlarını kaybedebilirsiniz. Web sitenizi taramadan önce bu dosyayı ve anlamını analiz etmek, tarama ile ilgili sorunlardan kaçınabileceğiniz anlamına gelir. Ayrıca, taranmasını istemediğiniz dizin hariç tutma sayfalarına web sitenizin içeriğinin eklenmesini engelleyebilirsiniz. Sitenizdeki belirli sayfalara erişimi kısıtlamak için bu dosyayı kullanın. Boş bir dosya varsa, şu adresten Robots.txt Bulunamadı Sorunu alabilirsiniz. SEO tarayıcısı.

Basit bir metin düzenleyiciyle bir dosya oluşturabilirsiniz. İlk olarak, talimatı yürütecek özel aracıyı belirtin ve disallow, noindex gibi engelleme yönergesini yerleştirin. Bundan sonra, taramayı kısıtladığınız URL’leri listeleyin. Dosyayı çalıştırmadan önce, doğru olduğunu doğrulayın. Bir yazım hatası bile Googlebot’un doğrulama talimatlarınızı görmezden gelmesine neden olabilir.

Robots.txt kontrol araçları neler yardımcı olabilir

robots.txt dosyası oluşturduğunuzda, herhangi bir hata içerip içermediğini doğrulamanız gerekir. Bu görevle başa çıkmanıza yardımcı olabilecek birkaç araç var.

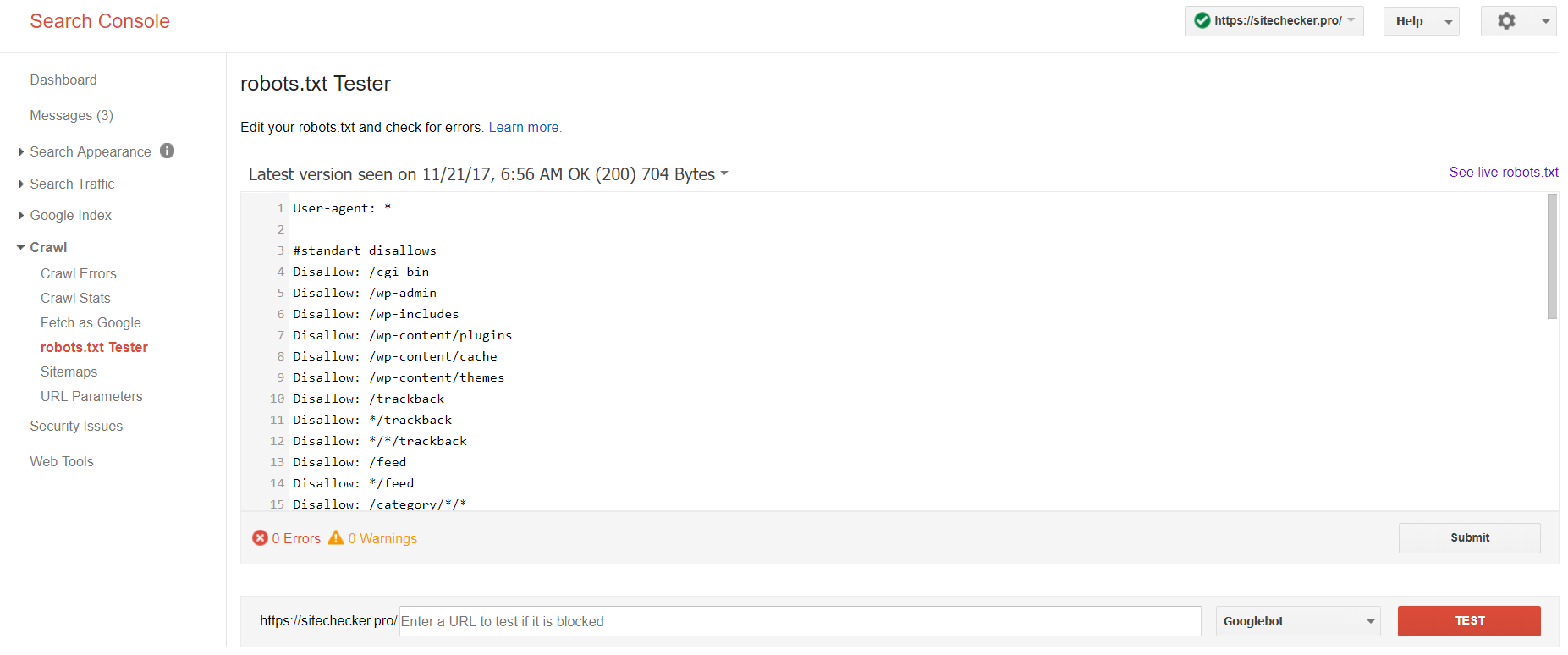

Google Arama Konsolu

Artık yalnızca Google Arama Konsolu‘nun eski sürümünde robots dosyasını test etmek için bir araç var. Platformunda onaylanmış mevcut site ile hesapta oturum açın ve doğrulayıcıyı bulmak için bu yolu kullanın.

Google Arama Konsolu > Tara > Robots.txt Test Aracı

Bu robot.txt testi şunları yapmanızı sağlar:

- tüm hatalarınızı ve olası sorunlarınızı bir kerede tespit edin;

- herhangi bir ek doğrulama olmadan yeni dosyayı sitenize yüklemek için hataları kontrol edin ve gerekli düzeltmeleri yapın;

- taramaktan kaçınmak istediğiniz sayfaları uygun şekilde kapatıp kapatmadığınızı ve dizine eklenmesi gerekenlerin uygun şekilde açılıp açılmadığını inceleyin.

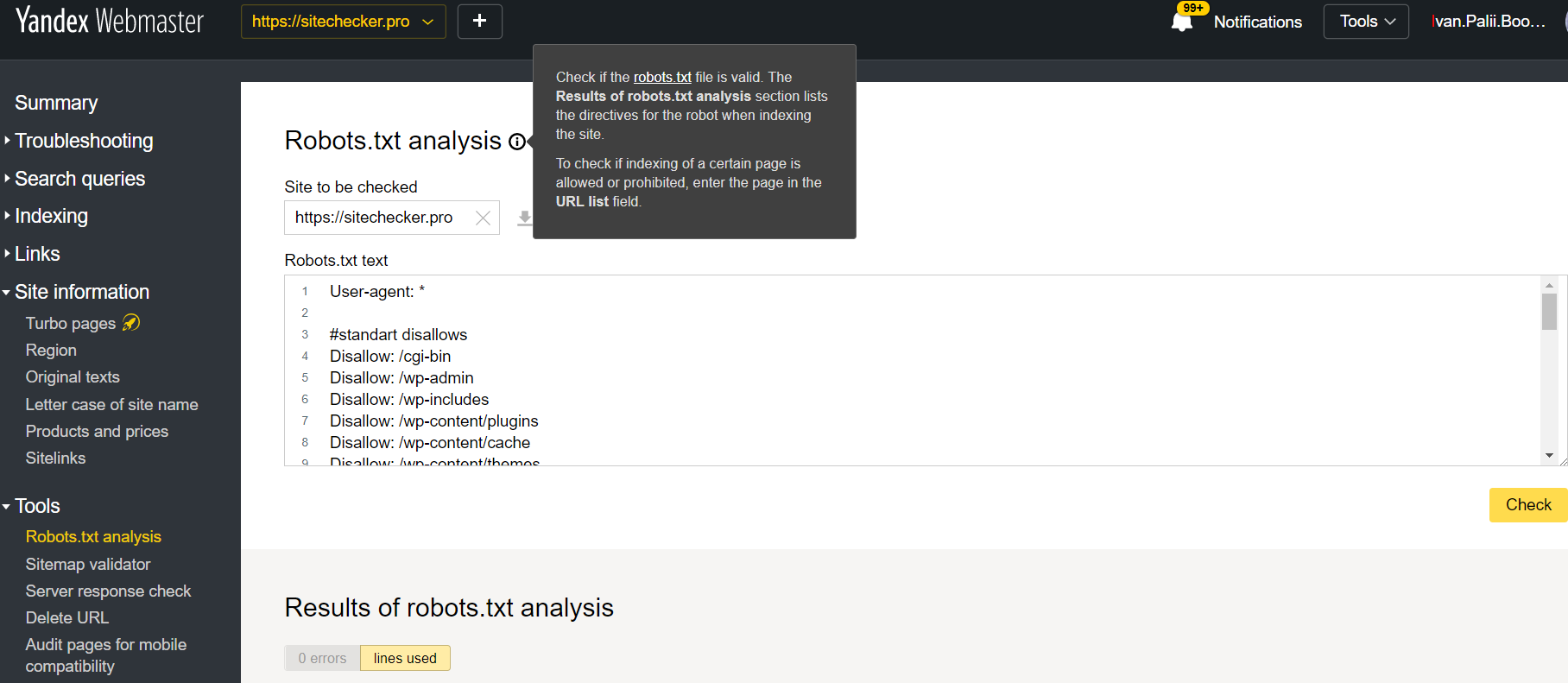

Yandex Web Yöneticisi

Geçerli site onayı ile Yandex Web Yöneticisi hesabında oturum açın platformunda onaylandı ve aracı bulmak için bu yolu kullanın.

Yandex Web Yöneticisi > Araçlar > Robots.txt analizi

Bu test cihazı, yukarıda açıklanan doğrulama için neredeyse eşit fırsatlar sunar. Fark şurada bulunur:

- burada robots.txt dosyanızın hemen doğrulanmasını sağlayan bir siteye yetki vermeniz ve bu sitenin haklarını kanıtlamanız gerekmez;

- sayfa başına eklemeye gerek yoktur: tüm sayfa listesi tek bir oturumda kontrol edilebilir;

- Yandex’in talimatlarınızı doğru bir şekilde tanımladığından emin olabilirsiniz.

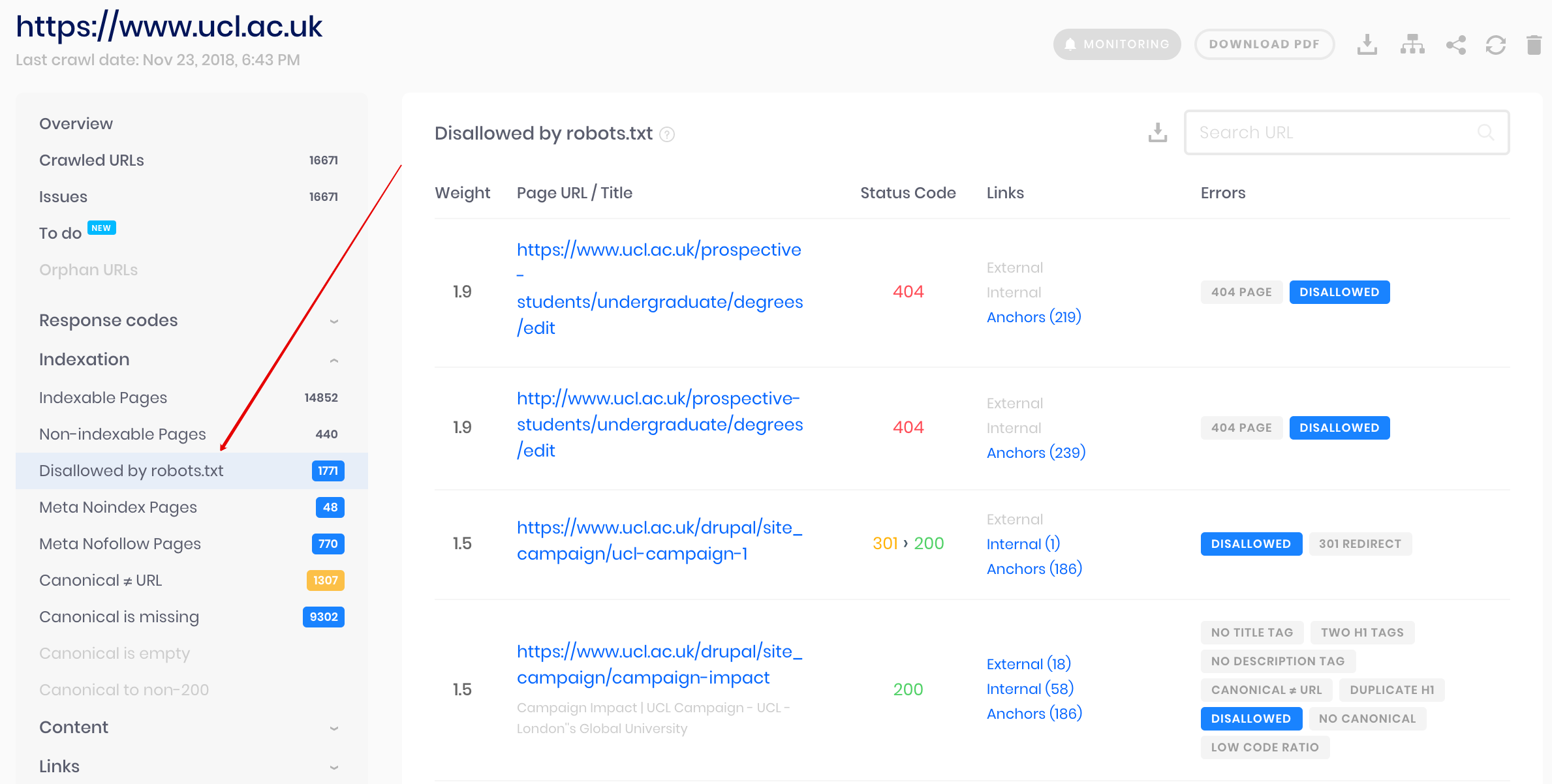

Sitechecker Tarayıcısı

Bu, web sitesini taramanız gerekiyorsa toplu kontrol için bir çözümdür. Tarayıcımız, tüm web sitesini denetlemeye ve robots.txt dosyasında hangi URL’lere izin verilmediğini ve noindex meta etiketi aracılığıyla hangi URL’lerin dizine eklenmesine kapalı olduğunu tespit etmeye yardımcı olur.

Dikkat: İzin verilmeyen sayfaları tespit etmek için web sitesini “robots.txt yoksay” ayarıyla taramanız gerekir.

Yalnızca robots.txt dosyasını değil, sitenizdeki diğer SEO sorunlarını da tespit edin ve analiz edin!

SERP sonuçlarınızı iyileştirmek için web sitenizdeki sorunları bulmak ve düzeltmek için tam bir denetim yapın.

Robots.txt Dosyamı Neden Kontrol Etmeliyim?

Robots.txt, arama motorlarına sitenizdeki hangi URL'leri tarayabileceklerini ve dizine ekleyebileceklerini gösterir, özellikle sitenizi sorgularla aşırı yüklememek için. Doğru çalıştığından emin olmak için bu geçerli dosyanın kontrol edilmesi tavsiye edilir.